| 需求 | 方案 |

| 想学习从0开始做面捕、了解VRCFT运行的流程 | 阅读全文 |

| 想了解成品面捕/面捕模版中的动画器用途,参数含义,同时有修改动画器的需求 | **[基本原理 | VRCD 文档库](https://docs.vrcd.org.cn/books/vrcfacetracking/page/a8f15)** **[动画器详解 | VRCD 文档库](https://docs.vrcd.org.cn/books/vrcfacetracking/page/eddea)** [制作/修改动画器 | VRCD 文档库](https://docs.vrcd.org.cn/books/vrcfacetracking/page/a4a04) |

| 面捕设备了解 | [关于设备 | VRCD 文档库](https://docs.vrcd.org.cn/books/vrcfacetracking/page/a02ff) [各个面捕数据的标准 | VRCD 文档库](https://docs.vrcd.org.cn/books/vrcfacetracking/page/ea5d2) |

| 软件安装及排错 | [软件下载及安装 | VRCD 文档库](https://docs.vrcd.org.cn/books/vrcfacetracking/page/4734b) [遇到的问题及解决方案 | VRCD 文档库](https://docs.vrcd.org.cn/books/vrcfacetracking/page/8f121) |

| TBD | TBD |

接下来基本会以ViveProEye(默认安装ViveFacialTracker)、QuestPro和Pico4Pro来展开介绍,因为这三款设备代表了三个不同数据标准,同时还是非常主流的头显。

| 品牌/厂家 | 设备名称 | 眼部 | 面部 | 数据标准 | 备注 |

| **HTC** | **Vive Pro Eye** | **√** | **-** | **SRanipal** | **搭配FacialTracker实现面捕捕捉** |

| HTC | Vive Focus 3 | - | - | SRanipal | 搭配特定设备实现面捕眼追捕捉 |

| HTC | Vive XR Elite | - | - | SRanipal | 搭配特定设备实现面捕眼追捕捉 |

| HTC | Vive Focus Vision | √ | √ | 未知 | 未发售,待更新 |

| **HTC** | **Vive Facial Tracker** | **-** | **√** | **SRanipal** | **通用配件(Type-c有线连接)** |

| HTC | Elite XR全脸识别追踪器 | √ | √ | SRanipal | 仅适配 XR Elite |

| HTC | Focus3面捕/眼球追踪器 | √ | √ | SRanipal | 仅适配 Focus3 |

| **Meta** | **Quest Pro** | **√** | **√** | **FACS Reduced** | |

| **Pico** | **Pico 4 Pro** | **√** | **√** | **ARKit** | |

| Pico | Pico 4 Enterprise | √ | √ | ARKit | |

| Varjo | Varjo Aero | √ | - | 未知(Tobii) | |

| Varjo | Varjo XR-3 | √ | - | 未知(Tobii) | |

| Varjo | Varjo VR-3 | √ | - | 未知(Tobii) | |

| Pimax | Crystal | √ | - | 未知(Tobii) | |

| Pimax | Droolon Pi 1 | √ | - | SRanipal | |

| Apple | iPhone(深度摄像头) | √ | √ | ARKit | |

| Android | Android Phone | √ | √ | 未知 | 需要使用Meowface app |

关于“标准”是什么,有什么区别,请看下一页

同时,还有一部分自制设备,可以搭配在Quest2/3、Index等设备上,需要较强的动手能力,同时在制作使用这些设备的时候,请注意安全,这里可以提供站内的一个自制方案: #### [Quest3面罩面捕方案(cymple) | VRCD 文档库](https://docs.vrcd.org.cn/books/quest3cymple) 而即使是都捕捉范围相同,但也有一定的精度差距 VRCFT的官方文档也有一个相关的表格[Tracking Compatibility | VRCFaceTracking (vrcft.io)](https://docs.vrcft.io/docs/hardware/interface-compatibilities),我在下面做一个简单的翻译。 页面中的不同设备各方面的表现按1-10的评分进行评估,表示其质量或效果。这些评分是基于设备之间的相对表现,依据例如表现力和质量等标准来打分。 **表现力**:指可追踪的动作/表情范围。表现力越高,面部细节追踪信息就越丰富。 **质量**:指追踪动作的效果/精度。质量越高,用户对动作/表情的控制就越好。| VIVE Pro Eye | VIVE Facial Tracker | Varjo (全系) | Meta Quest Pro | Pico 4 (Pro/Enterprise) | Pimax Droolon Pi1 | Pimax Crystal | |

|---|---|---|---|---|---|---|---|

| 类别 | 头显 | 配件 | 头显 | 一体机 | 一体机 | 配件 | 头显 |

| 面捕范围 | 眼睛 | 下脸 | 眼睛 | 全脸 | 全脸 | 眼睛 | 眼睛 |

| 目光 | ✔ | ~ | ✔ | ✔ | ✔ | ✔ | ✔ |

| 目光聚焦 | ✔ | ~ | ✔ | ❌ | ❌ | ❌ | ❌ |

| 眼睛开合 | 精细 | ~ | 精细 | 精细 | 精细 | 只有开与关 | 精细 |

| 瞳孔 | ✔ | ~ | ✔ | ❌ | ❌ | ❌ | ❌ |

| 上脸支持 | 瞪眼 挤眼 眉毛(模拟) | ~ | 瞪眼(模拟) 挤眼(模拟) | 瞪眼 挤眼 眉毛 | 瞪眼 挤眼 眉毛 | ❌ | ❌ |

| 上脸表现力 | 6/10 | ~ | 未知 | 9/10 | 8/10 | ❌ | ❌ |

| 上脸精度 | 8/10 | ~ | 未知 | 7/10 | 4/10 | ❌ | ❌ |

| 下脸支持 | ~ | 下巴 嘴唇 嘴 脸颊 | ~ | 下巴 嘴唇 嘴 脸颊 鼻子 | 下巴 嘴唇 嘴 脸颊 鼻子 | ~ | ~ |

| 下脸表现力 | ~ | 7/10 | ~ | 8/10 | 7/10 | ~ | ~ |

| 下脸质量 | ~ | 8/10 | ~ | 7/10 | 4/10 | ~ | ~ |

| 舌头支持 | ~ | 伸舌头及方向 | ~ | 伸舌头 | 伸舌头 | ~ | ~ |

| ARKit (iOS) | Project Babble | EyeTrackVR | VIVE Focus 3 专属Eye Tracker | VIVE Focus 3 专属Facial Tracker | HP Reverb G2 Omnicept | VIVE XR Elite 专属脸部追踪套件 | |

|---|---|---|---|---|---|---|---|

| 类别 | 软件/手机 | 软件 | 软件/自制设备 | 配件 | 配件 | 头显 | 配件 |

| 面捕范围 | 全脸 | 下脸 | 眼睛 | 眼睛 | 下脸 | 眼睛 | 全脸 |

| 目光 | 眼部表情 | ~ | ✔ | ✔ | ~ | ✔ | ✔ |

| 目光聚焦 | 无 | ~ | ✔ | ✔ | ~ | ✔ | ✔ |

| 眼睛开合 | 精细 | ~ | 精细 | 精细 | ~ | 只有开与关 | 精细 |

| 瞳孔 | ❌ | ~ | ❌ | ❌ | ~ | ✔ | ❌ |

| 上脸支持 | 瞪眼 挤眼 眉毛 | ❌ | ❌ | 瞪眼(损坏) 挤眼(损坏) | ~ | ~ | 瞪眼(损坏) 挤眼(损坏) |

| 上脸表现力 | 9/10 | ❌ | ❌ | 3/10 | ~ | ~ | 3/10 |

| 上脸精度 | 8/10 | ❌ | ❌ | 4/10 | ~ | ~ | 4/10 |

| 下脸支持 | 下巴 嘴唇 嘴 脸颊 鼻子 | 下巴 嘴唇 嘴 脸颊 鼻子 | ~ | ~ | 下巴 嘴唇 嘴 脸颊 | ~ | 下巴 嘴唇 嘴 脸颊 |

| 下脸表现力 | 8/10 | 9/10 | ~ | ~ | 7/10 | ~ | 7/10 |

| 下脸质量 | 8/10 | 8/10 | ~ | ~ | 7/10 | ~ | 7/10 |

| 舌头支持 | 伸舌头 | 所有舌头表情 | ~ | ~ | 伸舌头及方向 | ~ | 伸舌头及方向 |

| 眉毛相关数据 | 舌头伸出 | 舌头的上下左右移动 | |

| SRanipal | × | √ | √ |

| FACS Reduced | √ | √ | × |

| ARKit | √ | √ | × |

笔者:mouthClose和MouthClosed真的难绷,之前debug半天没找到原因,结果是因为少打了一个d

按照这样,那是不是每一个设备就得要按着不同的标准进行后续的处理呢?不!这就要介绍我们面捕的关键软件-VRCFT了!VRCFT,全称VRCFaceTracking,是一个无论什么面捕设备都能够使用的软件,这里先不展开对软件的介绍,我们需要了解的是VRCFT专用的标准:**UnifiedExpressions(UE)**

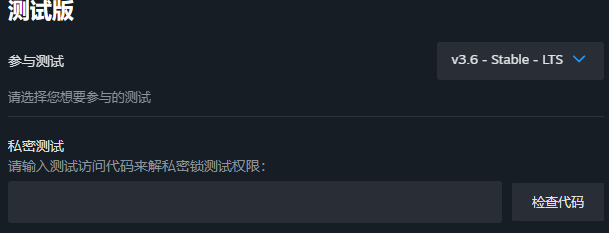

VRCFT其实也就是通过使用不同的模块将不同设备的面捕标准统一成 **UnifiedExpressions(下称UE)**,可以看作是一种抽象。这种抽象过程本质上是在不同的底层数据和协议上,提取出共性并进行整合,形成一个统一的接口和表达方式,方便开发者和用户在不同设备上获得一致的体验。 之后我们无论是讨论何种设备,以及后面的模型制作过程,都只是使用这个UE标准,这样就能保证我们做出来的模型能够在不同设备上使用了~ # 2. 软件层面 # 软件下载及安装 本页将介绍安装VRCFaceTracking(下称VRCFT) 方法一:打开VRCFT的Github,在Releases中选择版本进行下载,.msix和.appinstaller都是可以的。[VRCFT-Github](https://github.com/benaclejames/VRCFaceTracking) 如果您无法正常使用以上两种安装包安装VRCFT,则可以使用一种较为一般来说,推荐最新版本的VRCFT,但目前的问题是5.2.3.0中Force Relevancy没有实际效果,得回退到5.1.1.0,这就导致如果想使用Av3Emulator与VRCFT在Unity中使用OSC直接测试面捕效果的话,不能使用5.2.3.0。这条建议仅供拥有特殊需求的朋友参考。

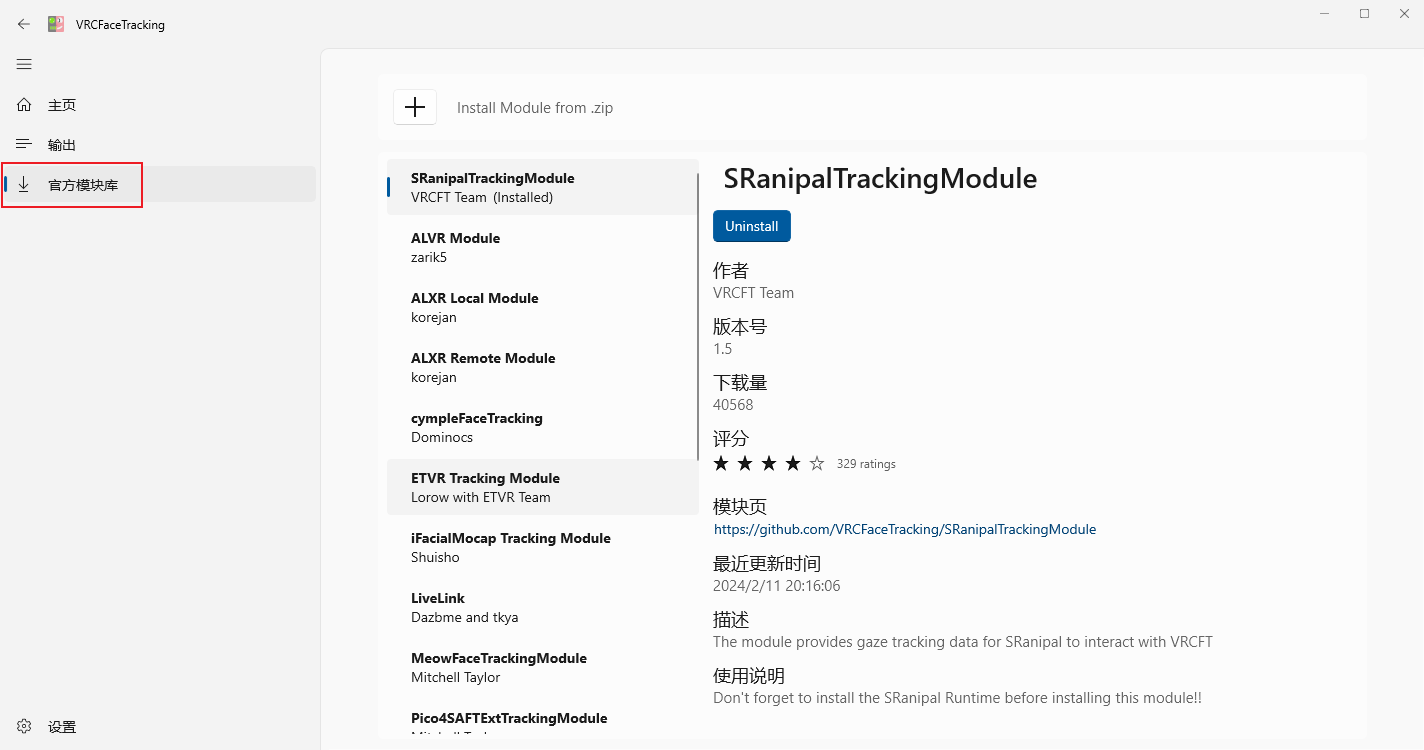

前文提过,我们需要一个模块来把我们不同标准转化成UE标准,在标注处下载对应的模块,或从此处安装本地模块包。 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/FOzJmBJ10fuoTkd3-image.png)有部分模块也许需要安装后重启VRCFT,若完全没有变化请尝试重启

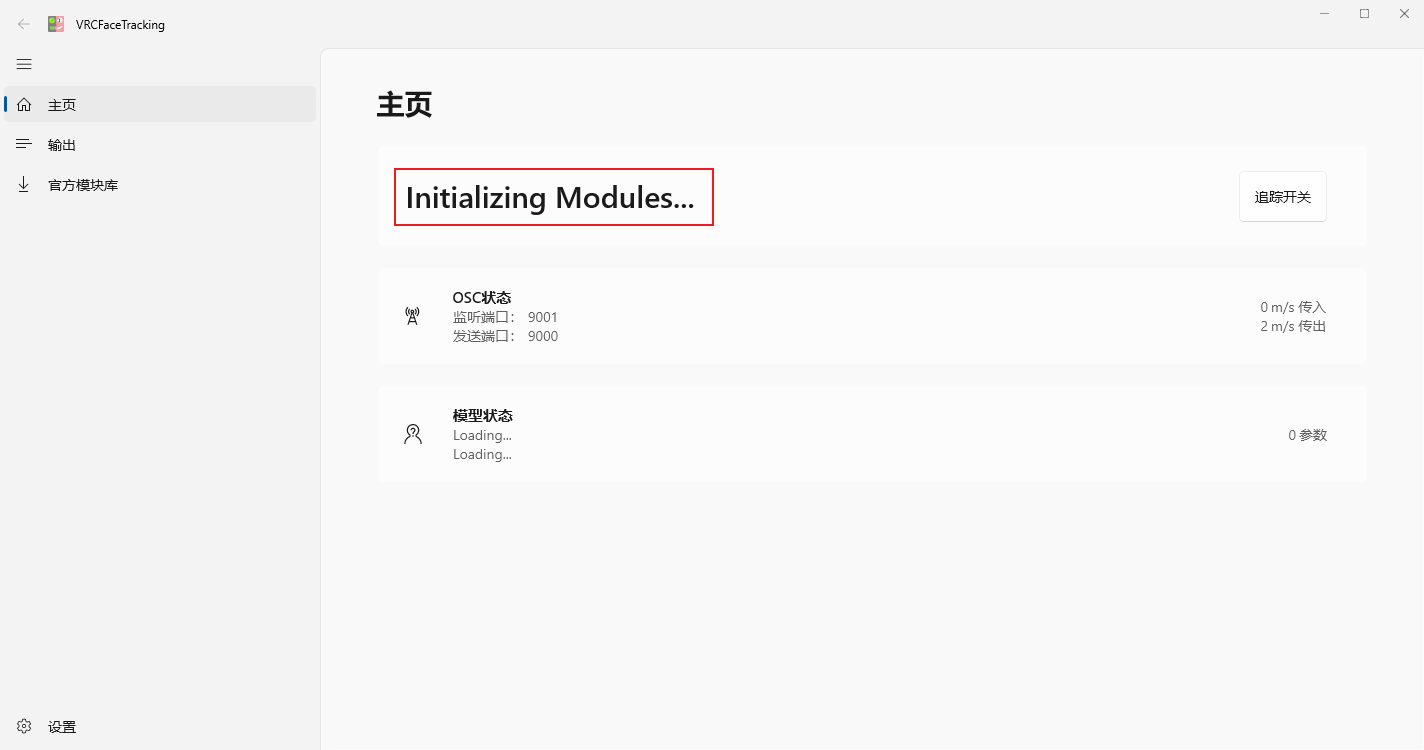

[](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/ZbwVgRPBmJrgU8hc-image.png) 初始化阶段正常安装和开启后,此处应该在Initializing Modules,随后进入对应模块效果而不是显示No Modules

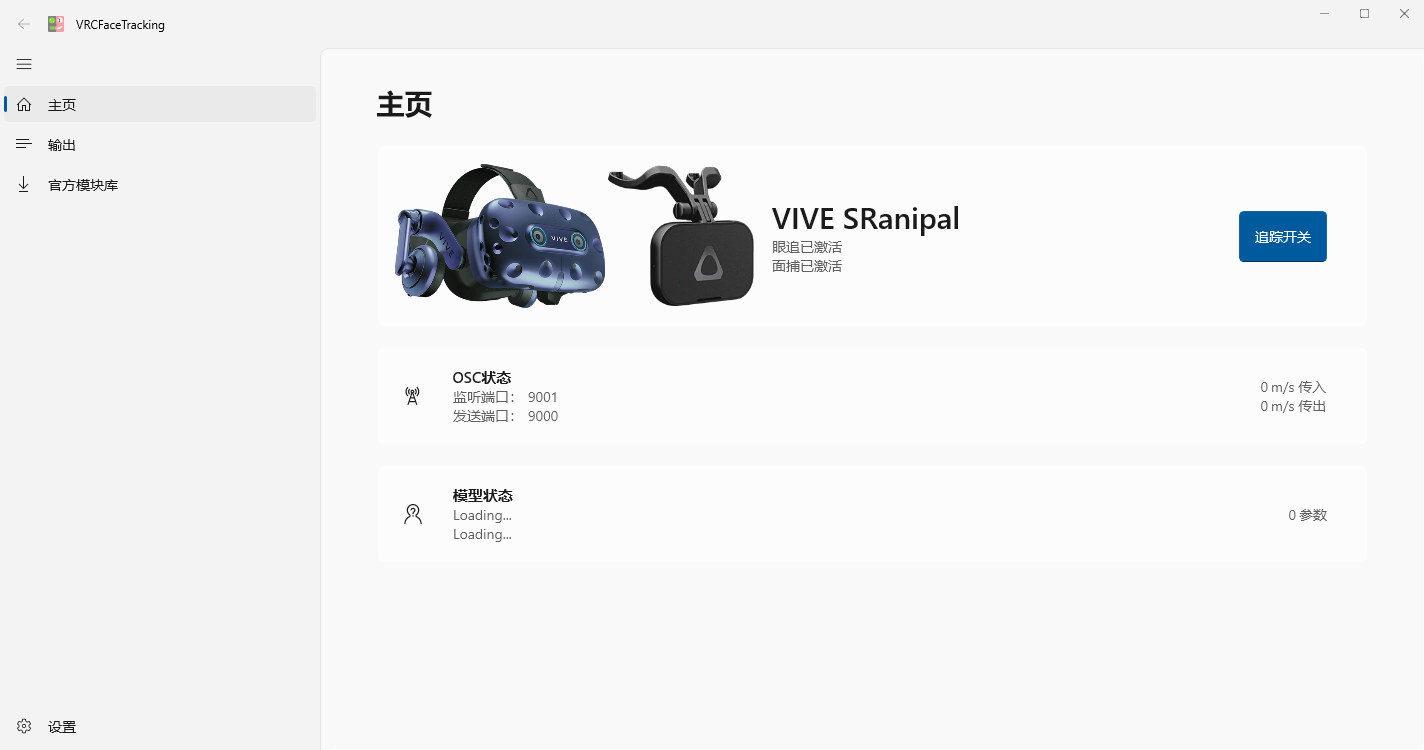

[](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/JXNbOxBmbCU6eO9i-image.png) 模块正常加载阶段如果您中途遇到了VRCFT的安装、使用问题或模块的加载出现了错误,请看本章节下一页。

##### 如果您的设备正常接入了VRCFT,一切都非常棒,那接下来我们需要做的就是制作模型了,请开始第三部分-模型层面。 # 遇到的问题及解决方案| int | 0 | 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| bool | 000 | 001 | 010 | 011 | 100 | 101 | 110 | 111 |

| float | 0 | 0.143 | 0.286 | 0.429 | 0.571 | 0.714 | 0.857 | 1 |

| bool | 000 | 001 | 010 | 011 | 100 | 101 | 110 | 111 |

如果增加Bool的数量,能够表达的int值就会更多,float值就会更加细致,但过度增加Bool不仅会徒增参数消耗,同时还收益不高

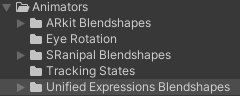

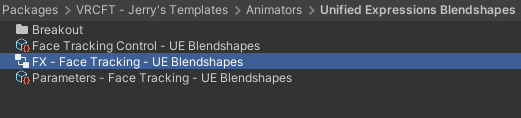

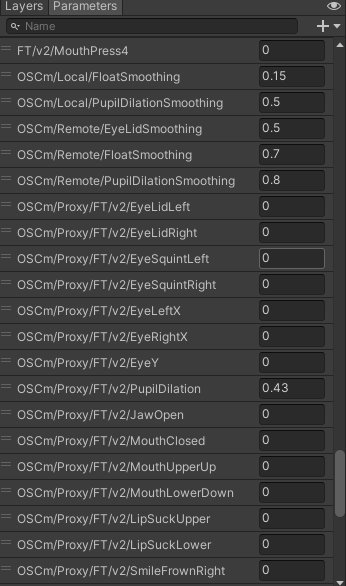

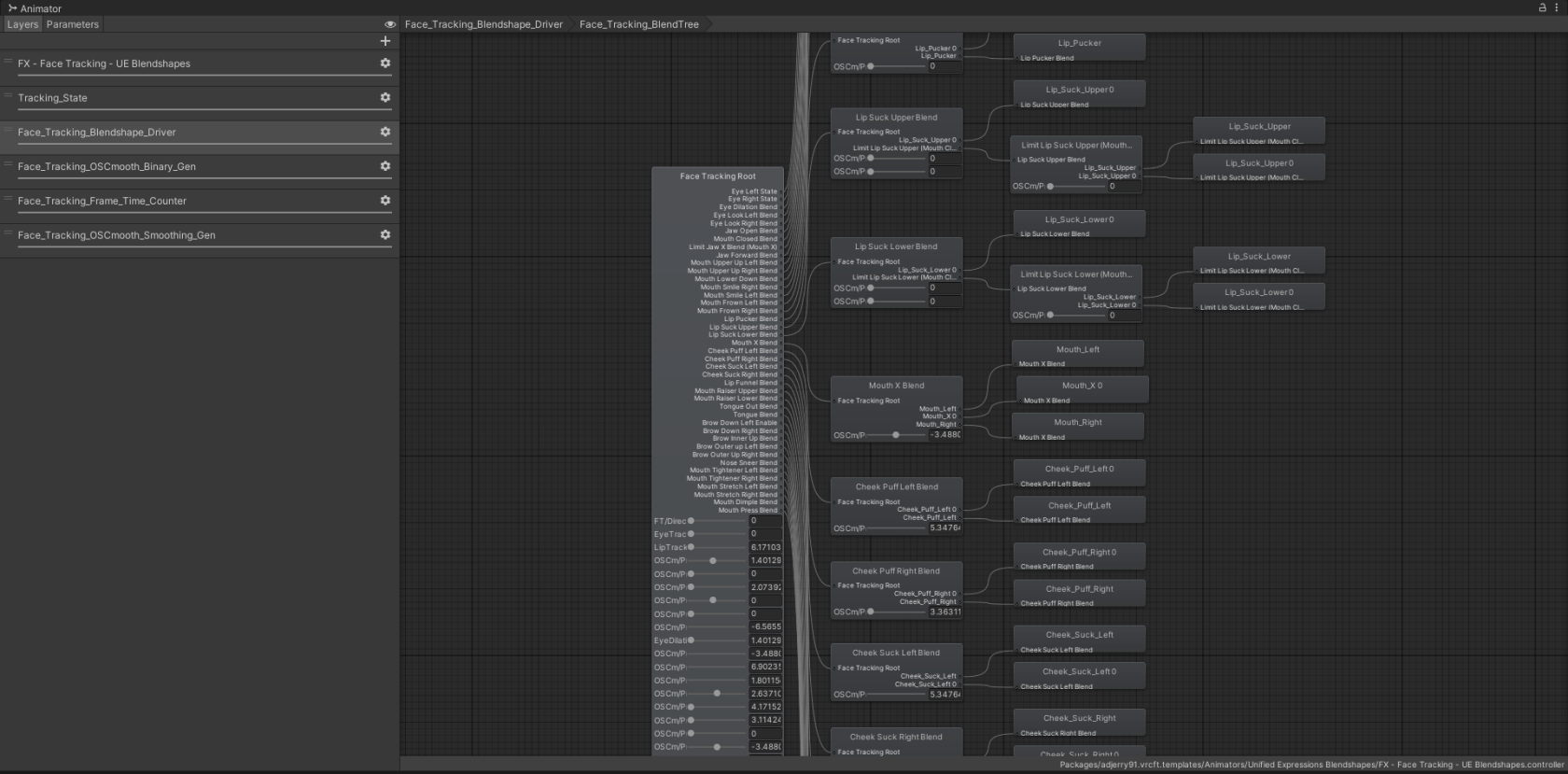

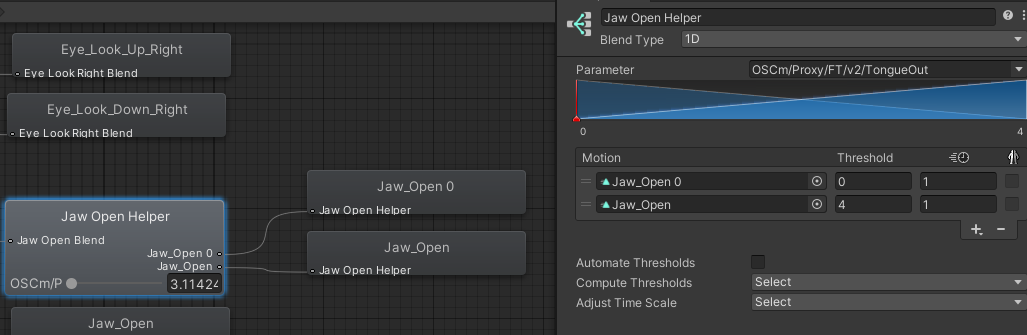

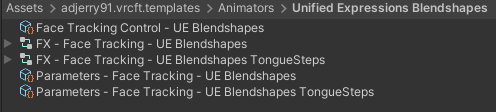

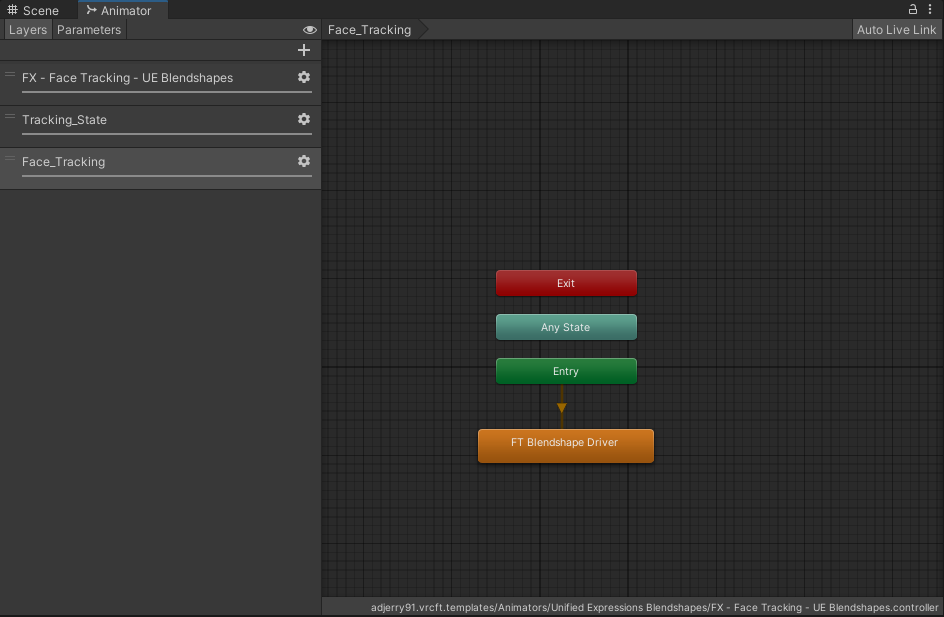

了解了这些,我们就可以准备接下来的内容了 # 模型形态键制作 本章节需要用到Blender,这里使用的版本是3.6,可以直接到Blender官网下载或者在Steam中切换测试版到3.6 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/u5JW9PMzLok6hbnD-image.png) 本页面需要有一定的Blender技巧 TBD # 动画器详解 我们现在以Jerry的Template来作为示范的例子,因为从0开始创造有一定难度,所以我们不妨先来看看成品是怎么样的。 Jerry的Template地址在这里:[VRCFT-Template](https://github.com/Adjerry91/VRCFaceTracking-Templates) 在早期版本,这个模板是直接在Asset目录下的,但在5.0版本之后,则需要在Package中寻找VRCFT - Jerry's Templates值得一提的是,Jerry的模板是使用VRC Fury来安装的,最方便的办法其实是用VRCFury的预制件直接丢入模型当中,但我们只是为了分析动画器,所以就直接使用资产中的Animator啦

Jerry的模板每一个版本都有可能发生一些排版、参数命名上的变化,所以本版本(6.2.1)仅供参考,但万变不离其宗,我们需要学的是里面的内容而不是冷冰冰的模仿出一个一模一样的面捕控制器

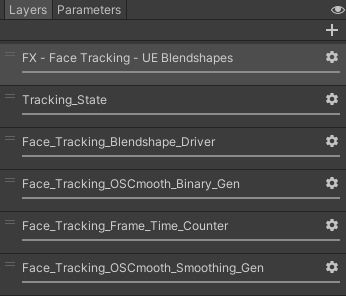

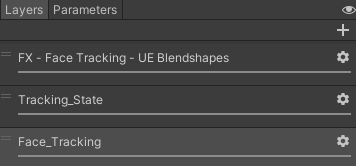

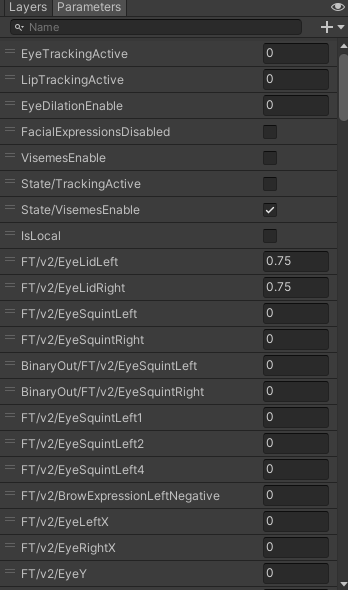

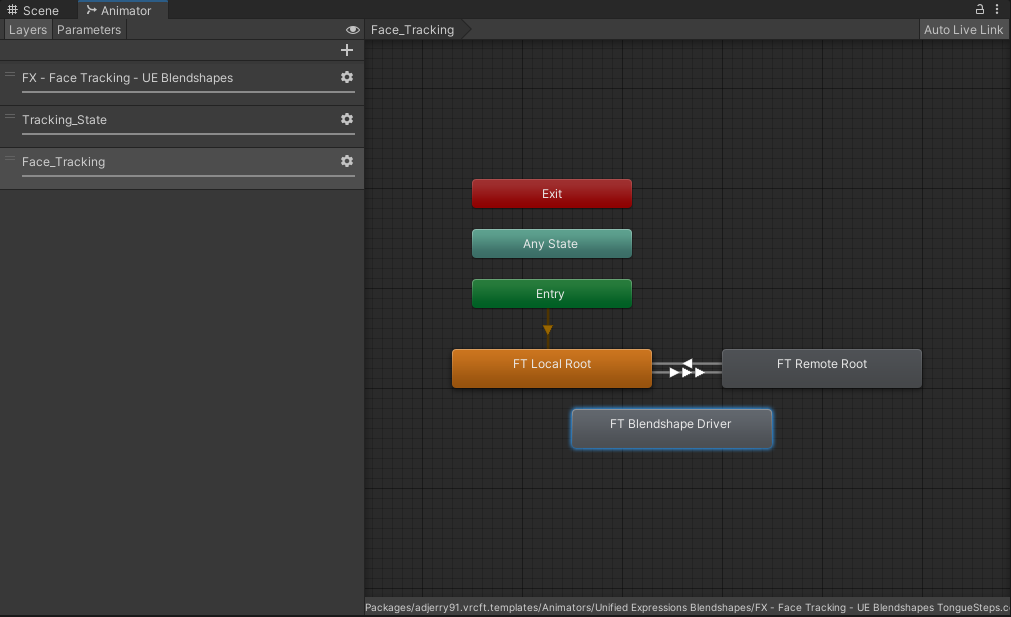

[](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/JX2diEDuwbnp14mm-image.png) [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/tSNeWZsC62bU7uZL-image.png) 在目录"VRCFT - Jerry's Templates\\Animators\\"中有各种标准的动画器,我们之前说过我们只使用UE标准,我们点击进入UE对应的Animator,FX - Face Tracking就是我们的对象啦。 #### **图层Layers**  正如我说的,不同版本之间差异很大,左图为6.2.1版本的Template,右图为6.3.3版本,他将左图中下面所有的图层整合进同一个图层了,方便分开学习,我们还是先使用左图来进行讲解

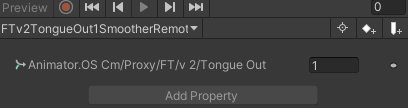

##### 各个图层Layers的含义如下: Tracking\_State:用于调整Avatar的追踪状态,主要使用AnimatorTrackingControl组件,组件文档详见[State Behaviors | VRChat Creation](https://creators.vrchat.com/avatars/state-behaviors/#animator-tracking-control) Face\_Tracking\_Blendshape\_Driver:用于直接驱动模型的形态键,**下称Driver图层** Face\_Tracking\_OSCmooth\_Binary\_Gen:用于对参数进行二进制压缩,详见[基本原理 | VRCD 文档库](https://docs.vrcd.org.cn/books/vrcfacetracking/page/a8f15),**下称Binary图层** Face\_Tracking\_Frame\_Time\_Counter:用于同步帧时间,缓解极高和极低帧率下的特殊情况 Face\_Tracking\_OSCmooth\_Smoothing\_Gen:用于对参数进行平滑处理,详见[基本原理 | VRCD 文档库](https://docs.vrcd.org.cn/books/vrcfacetracking/page/a8f15),**下称Smooth图层** #### **参数Parameters** [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/hci8FLQvI4rFVExr-image.png)[](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/Pbow6IwPZjHiUV05-image.png) ##### 各个参数Parameters的含义如下:| 参数名 | 动画器/本地 | 参数表/远程同步 | 描述 |

| EyeTrackingActive | Float | Bool | 眼球追踪开启 |

| LipTrackingActive | Float | Bool | 面部追踪开启 |

| EyeDilationEnable | Float | Bool | 瞳孔追踪开启(瞳孔放大缩小,仅Tobii系可用) |

| FacialExpressionsDisabled | Bool | Bool | 关闭手势表情 |

| VisemesEnable | Bool | Bool | 口型同步开启 |

| FT/v2/xxxxxx | Float | - | 原始输入的浮点值 |

| FT/v2/xxxxxx1;FT/v2/xxxxxx2;FT/v2/xxxxxx4 | Bool | Bool | 原始输入的布尔值,之后会经由Binary转换为BinaryOut/FT/v2/xxxxxx |

| BinaryOut/FT/v2/xxxxxx | Float | - | 经过Binary后的值,之后会经由Smooth转换为OSCm/Proxy/FT/v2/xxxxxx |

| OSCm/Proxy/FT/v2/xxxxxx | Float | - | 经过Smooth后的值,之后会在Driver图层直接驱动形态键 |

| OSCm/BlendSet | Float | - | 混合树同时进行的关键参数,请保持为1 |

| OSCm/Local/FloatSmoothing | Float | - | 本地参数的通用平滑程度 |

| OSCm/Local/PupilDilationSmoothing | Float | - | 本地参数的瞳孔平滑程度 |

| OSCm/Remote/EyeLidSmoothing | Float | - | 远程参数的眨眼平滑程度 |

| OSCm/Remote/FloatSmoothing | Float | - | 远程参数的通用平滑程度 |

| OSCm/Remote/PupilDilationSmoothing | Float | - | 远程参数的瞳孔平滑程度 |

小Tips: 在动画器页面单击F,可以显示全部的状态

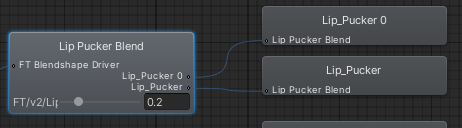

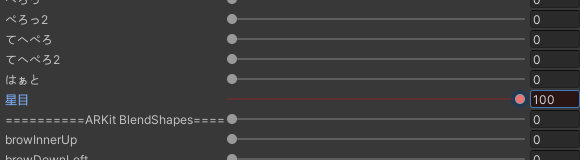

双击Face\_Tracking\_BlendTree可以进入混合树BlendTree页面 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/5in0XuDbvJmH4Fd5-image.png)在6.3.0版本之后则是在FT Blendshape Driver中,同样是双击点开,这里是最后一次做关于更高版本的Template的详细解释,之后的请参考混合树节点名称来自行判断图层。

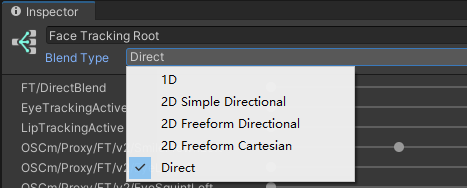

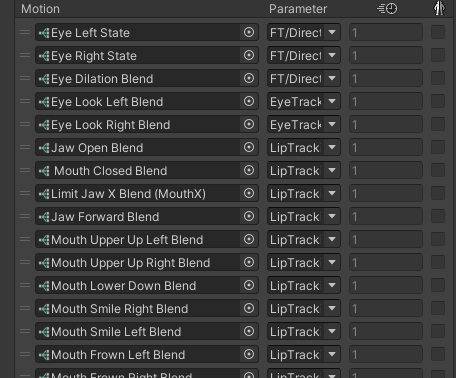

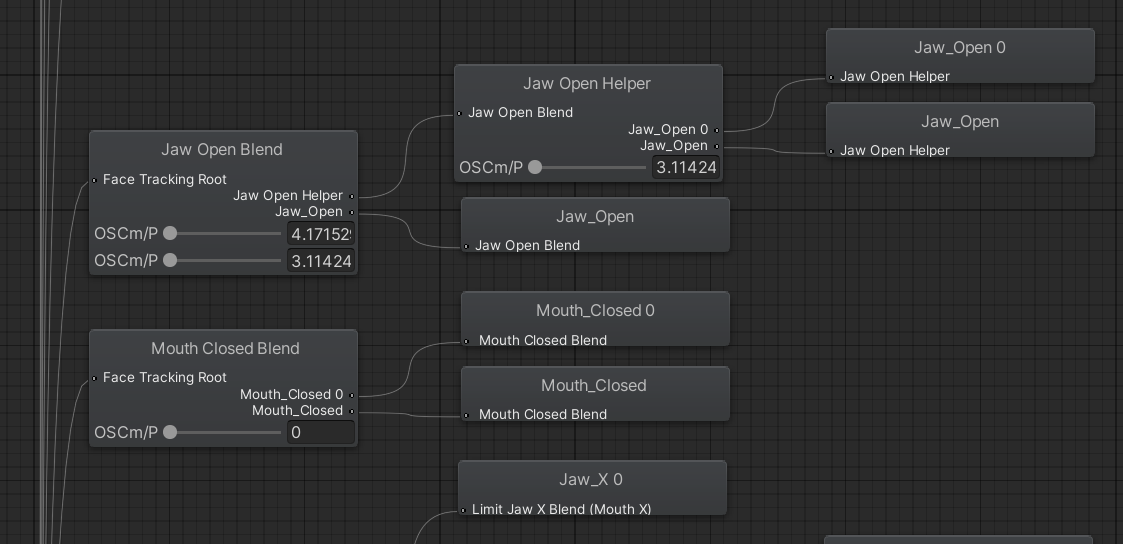

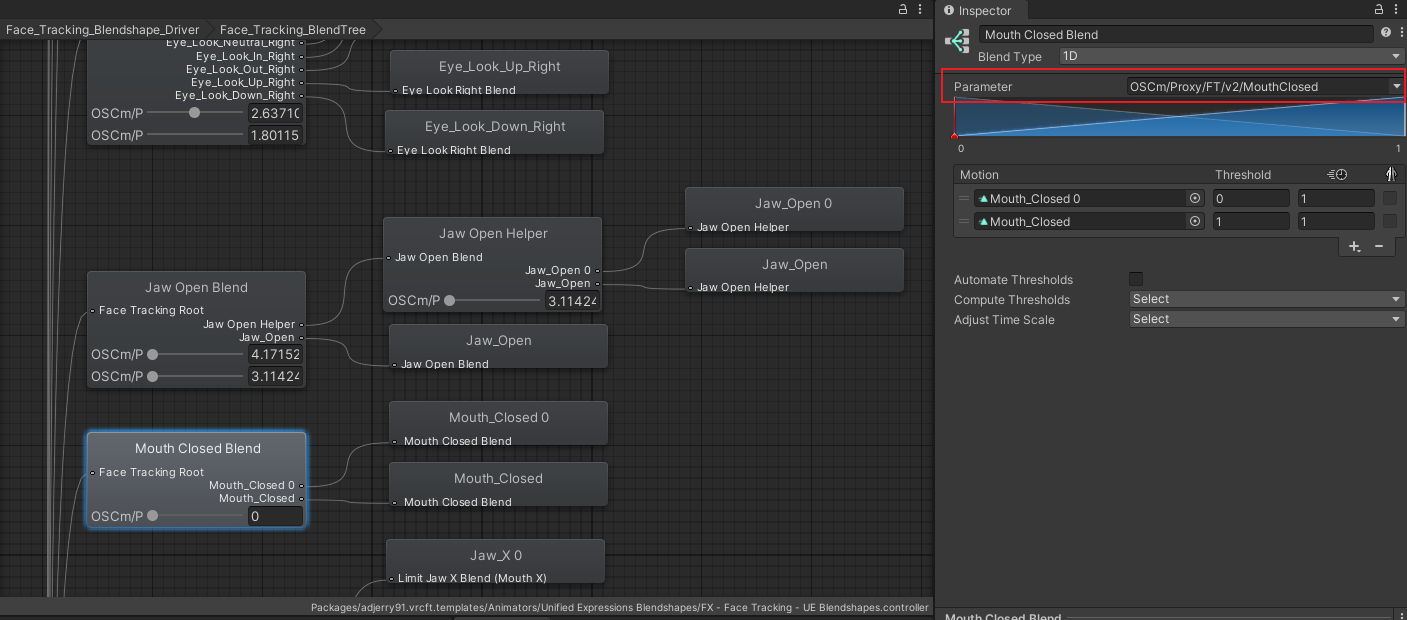

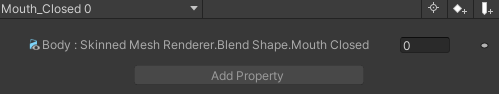

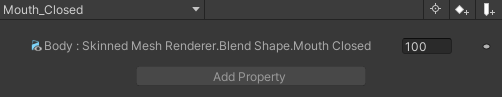

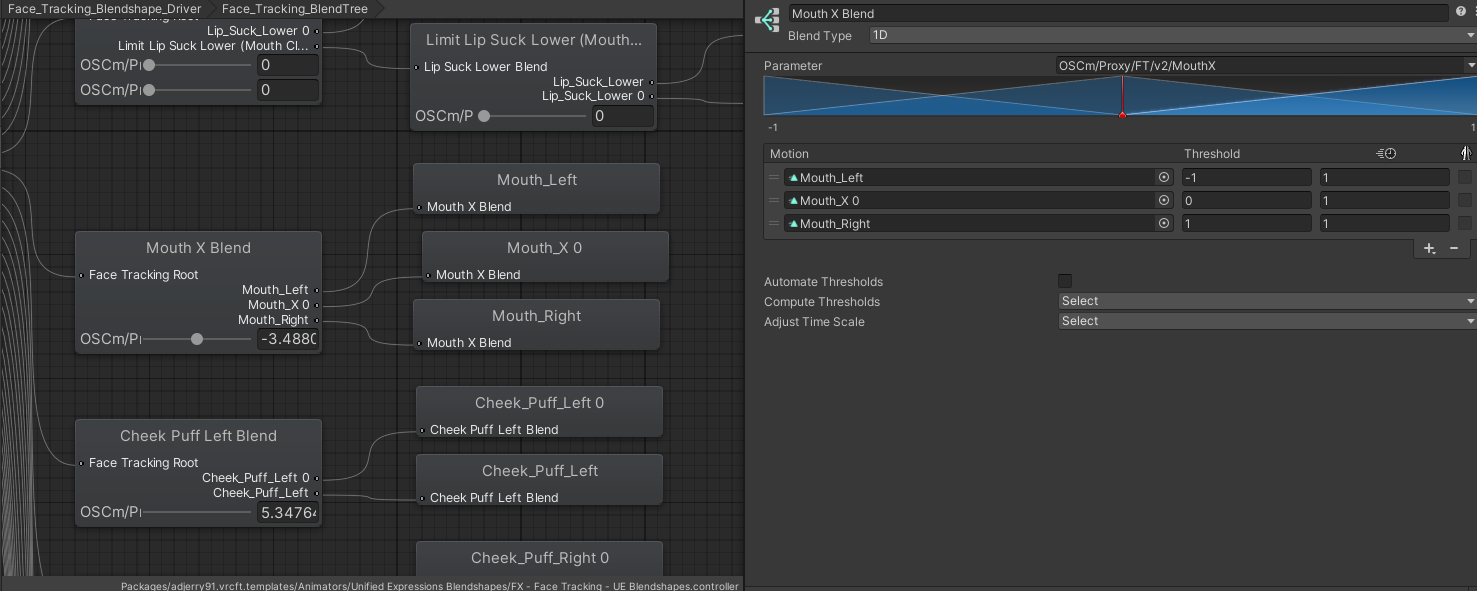

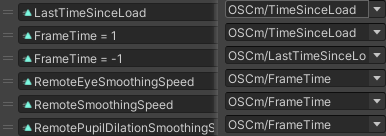

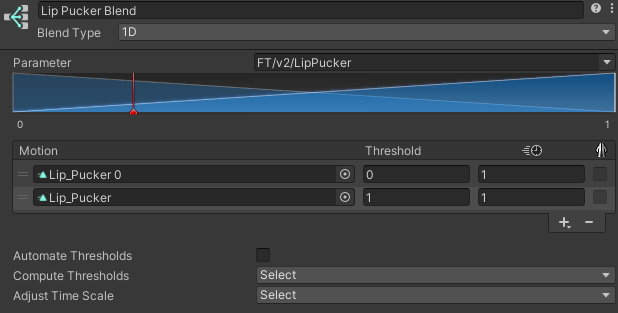

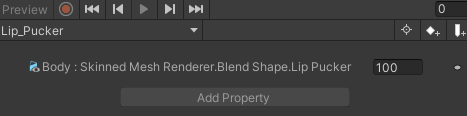

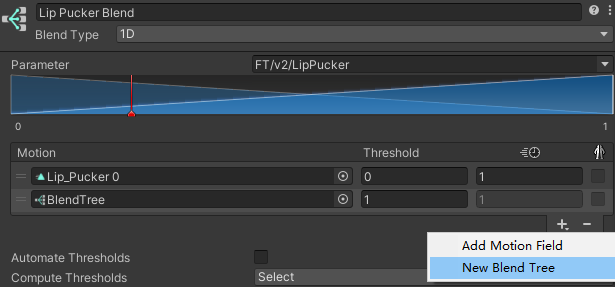

[](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/mjgLfKkEy5HIAvrI-image.png) ##### 各种混合树简易介绍 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/kxc3UotqG0P8LXby-image.png)[](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/76OaFEbY972r4nhf-image.png) **Direct类型**,则代表一旦满足**Parameter**中填入的参数,则会直接进入下一步,如果同时满足很多各**Motion**,则同时进入,例如我已经打开了LipTracking,也就是嘴部追踪,所有与嘴相关的,例如JawOpenBlend会运行。 接下来我们把目标聚集在Jaw Open Blend和Mouth Closed Blend,这是最简单的**1D类型**混合树 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/fY7NmHUdhLTnDWpJ-image.png) 我们先从简单的看起,MouthClosedBlend中右上角**Parameter**,填入了OSCm/Proxy/FT/v2/MouthClosed,说明由这个参数决定以下的**Motion。** 而**Threshold(阈值)**它代表了参数值对应的各个动画的激活范围,也可以理解为当这个参数到达多少的时候进入这个**Motion**,当控制参数的值在两个阈值之间时,Unity 会自动在两个动画之间进行平滑插值。**参数更靠近哪一边,哪一边的权重就更高。** 当OSCm/Proxy/FT/v2/MouthClosed=0时,执行动画Mouth\_Closed 0\*1.0 +Mouth\_Closed \* 0 当OSCm/Proxy/FT/v2/MouthClosed=**0.3**时,执行动画Mouth\_Closed 0 \* 0.7 + Mouth\_Closed \* 0.3 当OSCm/Proxy/FT/v2/MouthClosed=**1**时,执行动画Mouth\_Closed 0 \* 0 + Mouth\_Closed\*1.0 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/pTmSEyAcHuz40JDT-image.png) 而这两个动画也非常好理解,Mouth\_Closed 0让Body的MouthClose形态键为0,Mouth\_Closed让让Body的MouthClose形态键为100,当参数=0.5的时候,也就是在这两个状态的中点,那么形态键就会是50。 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/deF1qd2ggHzkvpqh-image.png)[](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/Qr4ad0um79qTF3zN-image.png)根据对阈值的简单了解,我们可以知道,参数\_A从0变到1的时候,形态键数据是从0变到100,那么如果想要修改一个动作,让动作更加灵敏,则可以通过**降低阈值**,来让形态键更快的达到100。

举个例子,如果我把MouthClosed的阈值从1改成了0.7,那么在参数=0.7的时候,形态键=100;参数=0.35的时候,形态键=50,这样能够让形态键更快的到最大值,当然这样也会导致更加的灵敏,缺点就是,参数只要大过0.7,形态键都是在100,不会变。

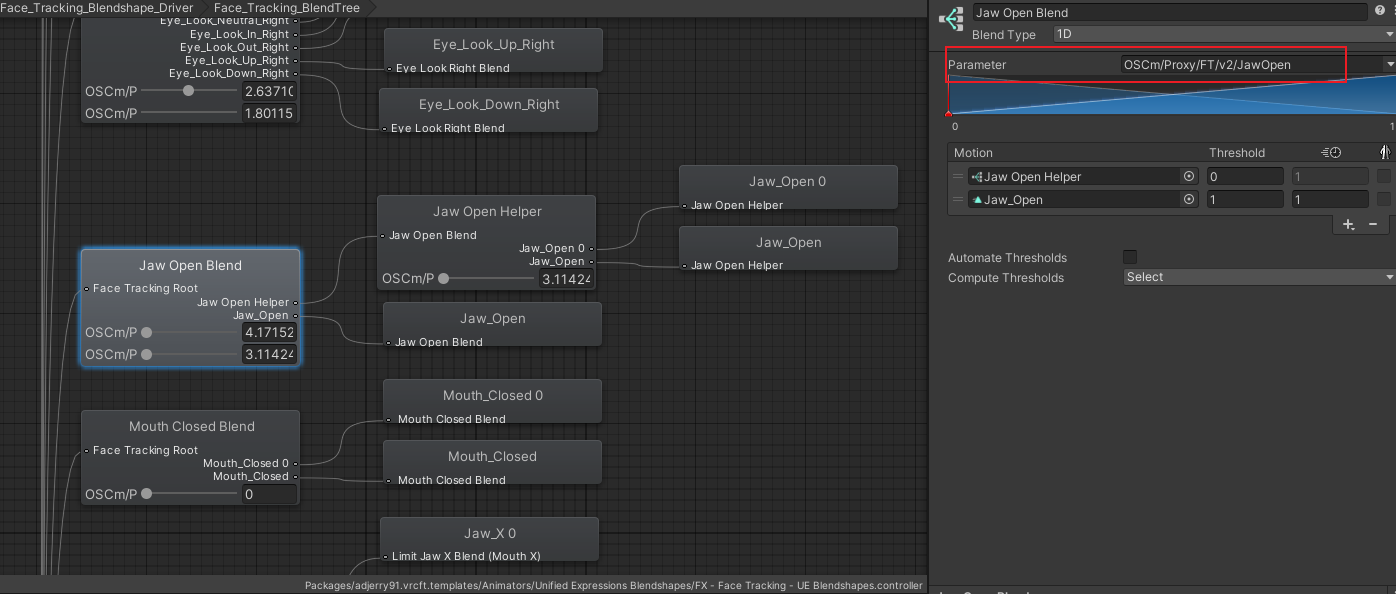

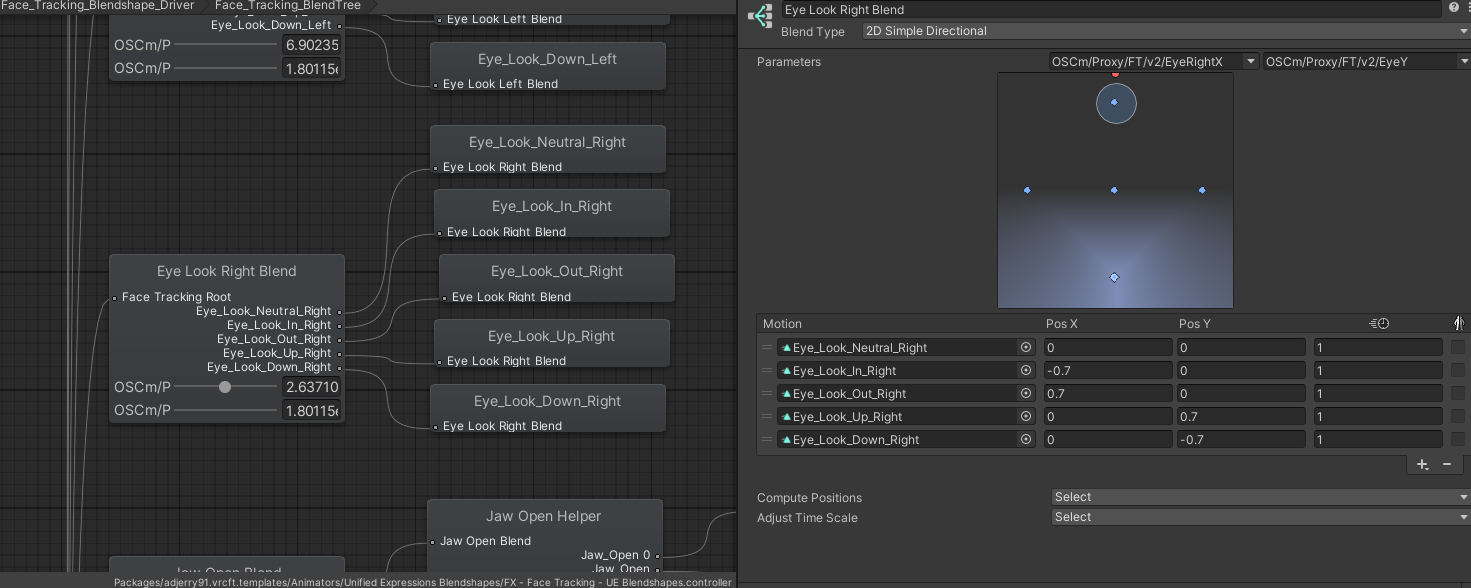

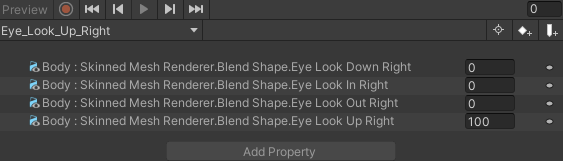

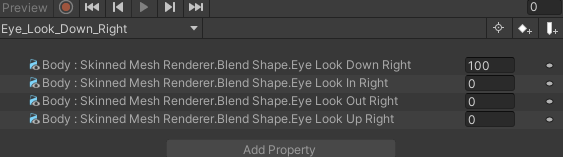

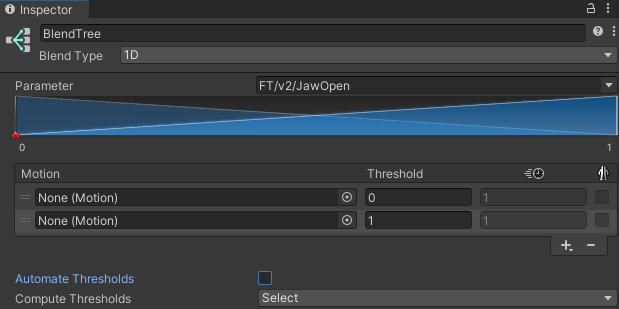

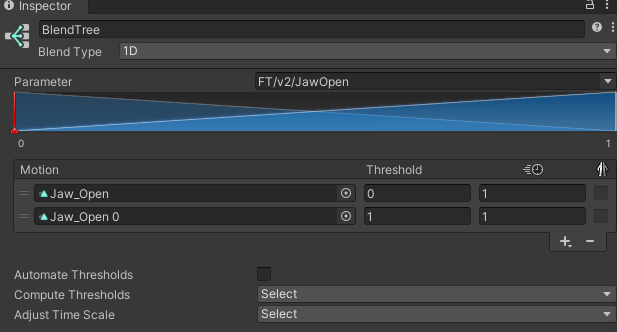

而JawOpenBlend右上角是使用的OSCm/Proxy/FT/v2/JawOpen,那么,当参数=0时,则进入JawOpenHelper这个**Motion**,参数=1时,进入Jaw\_Open这个动画,而JawOpenHelper这个**Motion**,是另一层**嵌套上去的Blendtree**。 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/dSBynWLNXW2GV69U-image.png) [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/d9O1x349VcNiRL9l-image.png) 而这个Helper也是同样的**1D混合树**,控制Jaw\_Open相关动画。所以我们可以知道,为了实现形态键JawOpen=1,有几个路线: 1. OSCm/Proxy/FT/v2/JawOpen=1 2. OSCm/Proxy/FT/v2/JawOpen=0 但是 OSCm/Proxy/FT/v2/TongueOut=4 **这个的思路就是:当我的设备检测到我的JawOpen打开了,那就是真的打开了,直接让模型的JawOpen也为1;但是有的时候我伸舌头TongueOut=1了,如果这时候设备检测到我的JawOpen其实为0,如果我直接伸出舌头会穿模,所以我让他用舌头的参数控制一点点的JawOpen,让嘴巴微微打开,让舌头伸出来不穿模。** 还有一些Blendtree使用的参数是有负数值的,例如MouthX一个参数即可表示左和右 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/37Z2LFEW9LkQPEcd-image.png) 接下来是**2D类型**的混合树,图上所示的是右眼球的移动轨迹,参数为OSCm/Proxy/FT/v2/EyeRightX和OSCm/Proxy/FT/v2/EyeRightY,这说明有两个参数同时控制了这个混合树,而PosX则是对应左边那个参数的设置,PosY对应的则是右边,我们不难理解每一个位置对应的动作。 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/4FduIudYgqImkpBf-image.png)值得一提的是,这种类型的混合树录制动画的时候请让其他相冲的形态键为0

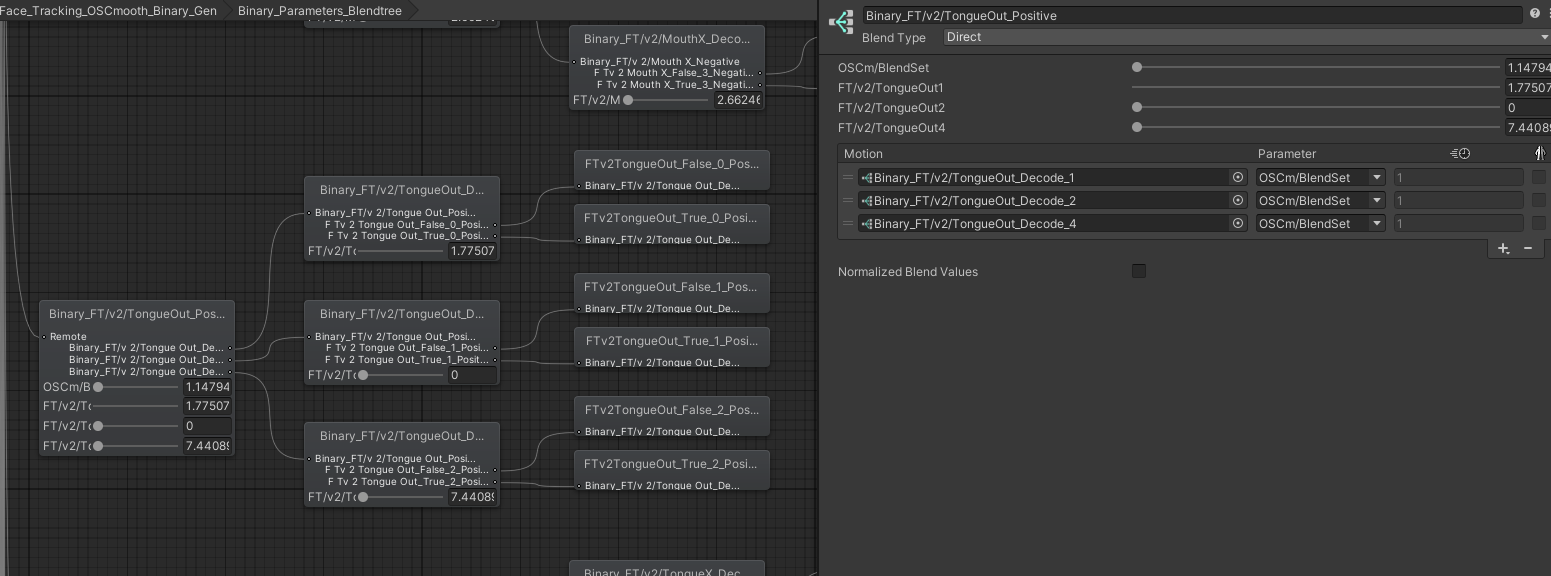

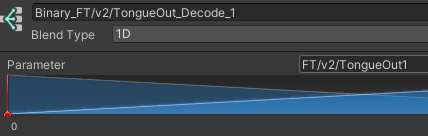

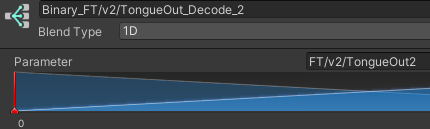

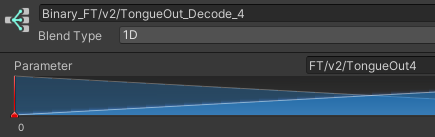

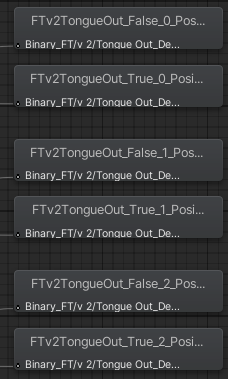

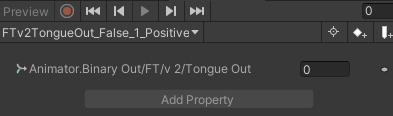

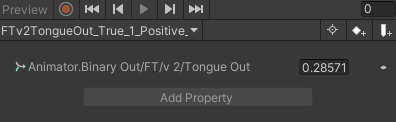

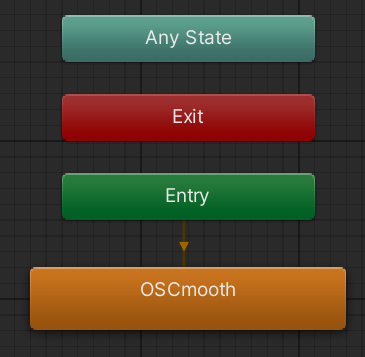

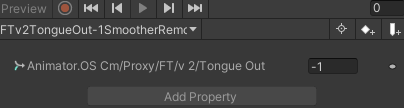

[](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/2J2NOTzT9SYRnV4s-image.png) [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/q6wmdxOxdvAlcGtr-image.png) ##### 关于其他2D混合树,这里贴出Unity官方的文档进行解释: \_\_2D Simple Directional\_\_:最好在运动表示不同方向(例如“向前走”、“向后退”、“向左走”和“向右走”或者“向上瞄准”、“向下瞄准”、“向左瞄准”和“向右瞄准”)时使用。根据需要可以包括位置 (0, 0) 处的单个运动,例如“空闲”或“瞄准”。在 Simple Directional 类型中,在同一方向上\_不\_应该有多个运动,例如“向前走”和“向前跑”。 \_\_2D Freeform Directional\_\_:运动表示不同方向时,也使用此混合类型,但是您可以在同一方向上有多个运动,例如“向前走”和“向前跑”。在 Freeform Directional 类型中,运动集应始终包括位置 (0, 0) 处的单个运动,例如“空闲”。 \_\_2D Freeform Cartesian\_\_:最好在运动不表示不同方向时使用。凭借 Freeform Cartesian,X 参数和 Y 参数可以表示不同概念,例如角速度和线速度。一个示例是诸如“向前走不转弯”、“向前跑不转弯”、“向前走右转”、“向前跑右转”之类的运动。 ### **2. Binary图层内容详解** [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/oYTY3KE7V9slqKDq-2024-09-19-23-29-06-1.gif) 图上就是一个Binary的最终实现的效果,通过输入TongueOut1、TongueOut2、TongueOut4,输出不同的BinaryOut/FT/v2/TongueOut值,最后经过平滑转为OSCm/Proxy/FT/v2/TongueOut 那接下来我们一样是双击进入混合树,开始我们的Binary部分 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/4XUfoczyFWYbKMFk-image.png) [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/tbLtAhKFBzhIDH3c-image.png) 根部分与Driver几乎一样,都使用了**Direct类型**的混合树,同时驱动多个混合树。我们以TongueOut为例,可以看到同样使用了**Direct类型**,所使用的参数为默认为1的参数,则同时进行三个**Motion**的混合。 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/eC5liLkymZQce2Tb-image.png) 而这三个嵌套的Blentree使用参数分别为FT/v2/TongueOut1、FT/v2/TongueOut2、FT/v2/TongueOut4,对应的动画命名均为 **参数名+False/True+Postive/Negative+GUID** [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/jYMRndzuOb6oHVwj-image.png)[](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/NPlZHJeMoWW1ug51-image.png)[](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/JczvcXzZvAXCqd6P-image.png) [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/57exIp1LrLN6PLTF-image.png) [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/lLdDnSEP6op5BN7S-image.png)[](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/WEvVmyJxC0a9clHI-image.png) 这是一个特殊的关键帧,这是直接驱动动画器中对应的参数的关键帧,含义是将BinaryOut/FT/v2/TongueOut设置成0和0.28571,同时还有类似0.57143、0.14286,具体的取值不详细解释了,在上一页**基本原理**中有讲到,是**二进制压缩**的内容。一般途径无法直接录制这个关键帧,通常在.anim文件中直接修改,或者使用代码生成,当这类关键帧启动的时候,动画器内被驱动的数值则会无法输入

Positive/Negative是区分类似MouthX这种有负值的参数使用的

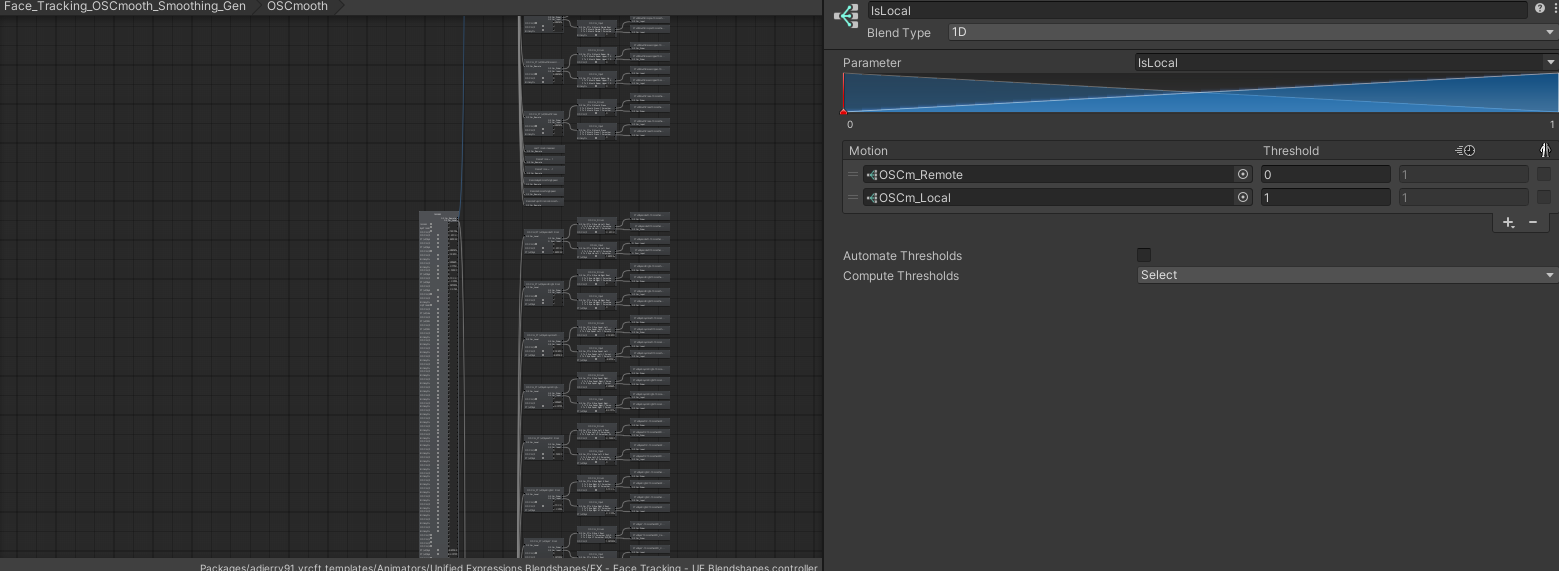

当三个动画同时被驱动的时候,就能够将各自驱动的数值相加混合起来,也就是最开始这张图。 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/oYTY3KE7V9slqKDq-2024-09-19-23-29-06-1.gif) ### **3. Smooth图层内容详解** [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/1IYm8NAW6PjIMkzi-image.png)本版本是直接整合到同一个State中,本地和远端共用同一个Blendtree,视版本不同可能会存在差异。

同样是双击进入混合树中,这里因为混合树节点数量太多,无法截全图,根节点的效果就是使用**IsLocal**来判断进入的是远端还是本地的平滑。所谓远端,其实就是其他玩家看见你的模型的时候,也会同步加载你模型的所有FX等动画器,这时候动画器中的IsLocal就会为False/0,这时候就进入对应的远端平滑流程。而本地加载这个动画器的时候,就会是IsLocal为True/1,对应进入本地平滑流程。

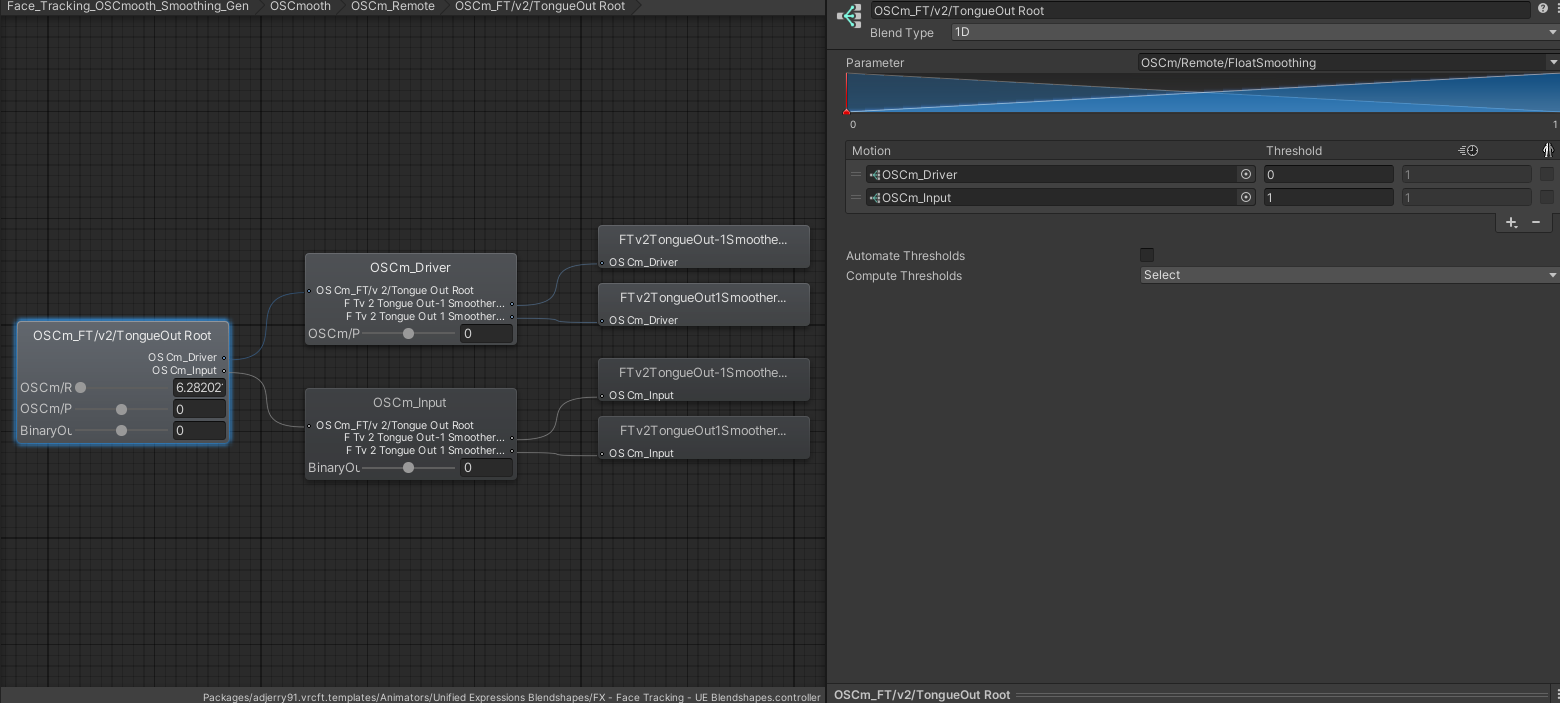

[](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/qqpFoEwHy8JGpGVd-image.png) 现在以**OSCm\_Remote**为例,OSCm\_Local也是同理,可以参考。**OSCm\_Remote**使用了**Direct类型**进行混合,我们选择**TongueOut Root**进行解释。 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/IqWjCubXAlHcEgqu-image.png) 参数是**OSCm/Remote/FloatSmoothing**,我们本页说过,这是远端使用的平滑参数,决定了平滑程度。 假设我们这个**OSCm/Remote/FloatSmoothing=0.3**,那么对应在上图就是,**0.7\*Driver+0.3\*Input**根据Jerry模版中这个Blendtree,当**OSCm/Remote/FloatSmoothing**越靠近1则越靠近OSCm\_Input,越靠近0则越靠近OSCm\_Driver,最终导致的情况是相反的(OSCmooth自动生成的是0是Input,1是Driver),所以我们后续制作的时候需要注意。

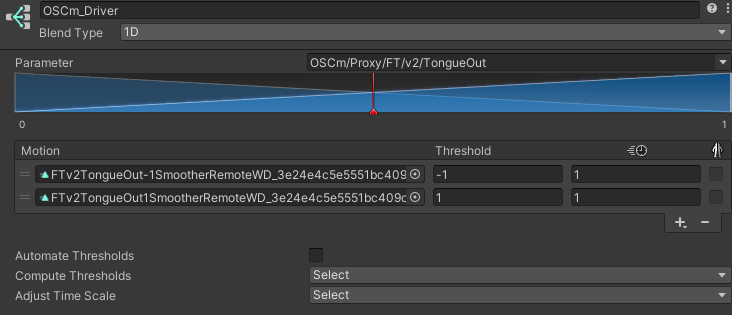

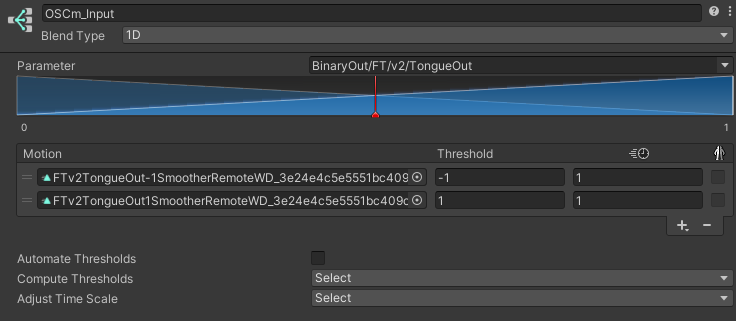

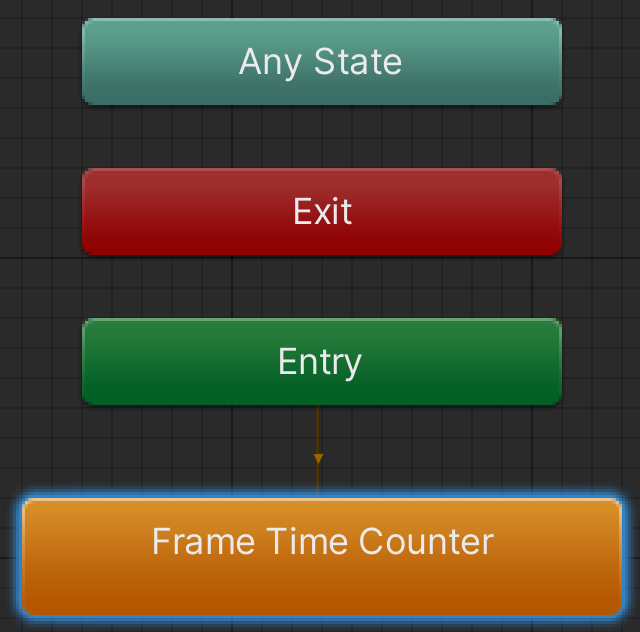

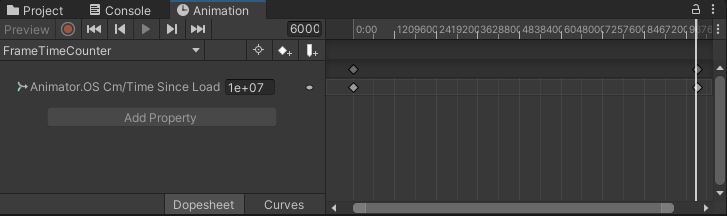

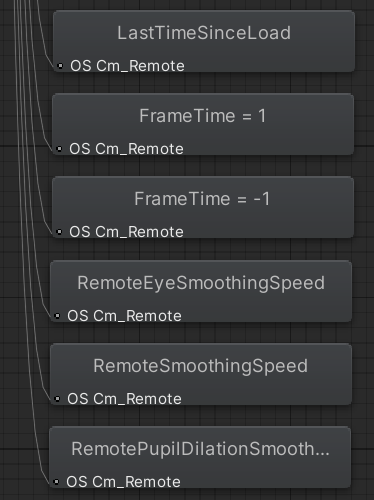

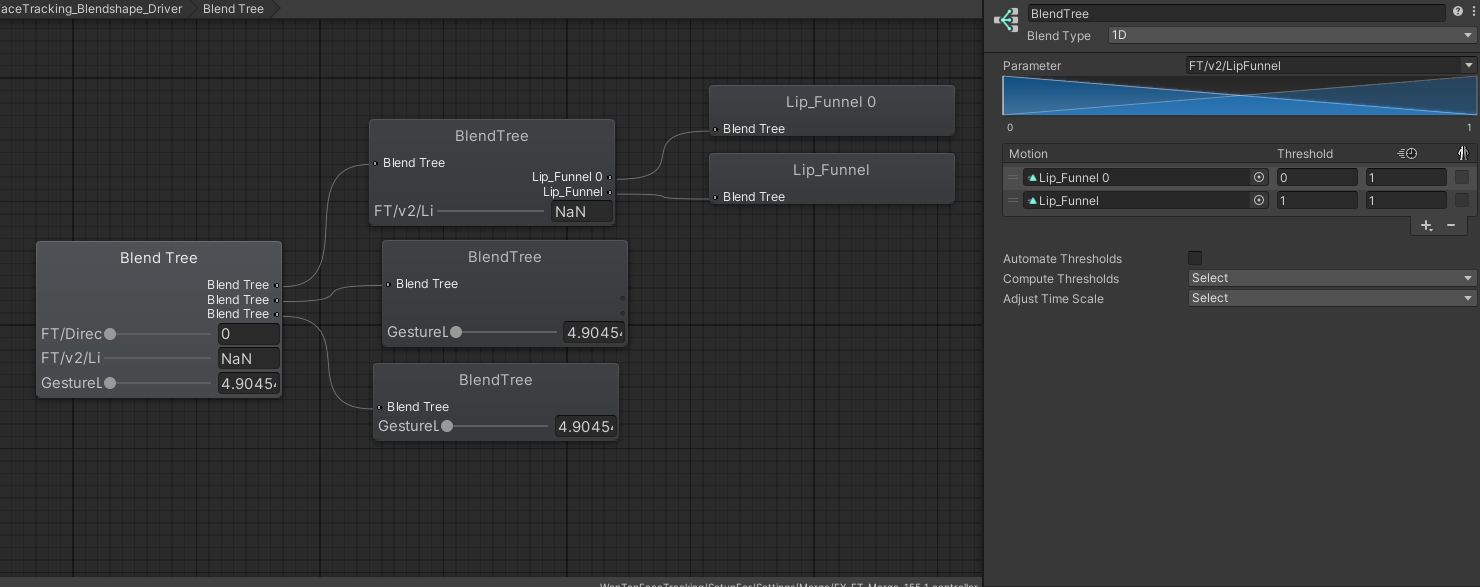

那接下来看OSCm\_Driver和OSCm\_Input,他们所使用的动画都是一样的,命名规则为: **参数名+-1/1+Smoother+(Remote)+GUID** Driver使用的参数为:OSCm/Proxy/FT/v2/TongueOut Input使用的参数为:BinaryOut/FT/v2/TongueOut(在Local版本中,使用的是FT/v2/TongueOut) [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/cFZSXSOqtZ7CrgdK-image.png) [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/XChfDUdYUJtaDn3P-image.png) [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/ZmYeQhOEq5VwoR4p-image.png)[](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/gBM7ZhIf41Wep9rm-image.png) 动画文件则是之前提过的,驱动OSCm/Proxy/FT/v2/TongueOut,而这么做呢,能够让这个最后被驱动的参数得到一个平滑的过渡。 我们举个例子,假设**OSCm/Remote/FloatSmoothing=0.3**,那此刻,混合树进行的混合运算为Input\*0.7 + Driver\*0.3 然后我们现在将**BinaryOut/FT/v2/TongueOut**更改为1,而这个参数则会影响Input,驱动OSCm/Proxy/FT/v2/TongueOut=1,我们上面说的混合树计算,现在就变成了OSCm/Proxy/FT/v2/TongueOut=1\*0.7,实际上这个参数只变成了0.7 同时Driver中**初始值为0**的OSCm/Proxy/FT/v2/TongueOut自然也就不会变化,那就是OSCm/Proxy/FT/v2/TongueOut=0\*0.3 最终就是OSCm/Proxy/FT/v2/TongueOut=1\*0.7 + OSCm/Proxy/FT/v2/TongueOut=0\*0.3 = OSCm/Proxy/FT/v2/TongueOut=0.7 这个平滑是递进的,那这时候再次进行的时候,OSCm/Proxy/FT/v2/TongueOut初始值为0.7,这时候就是 OSCm/Proxy/FT/v2/TongueOut=1\*0.7 + OSCm/Proxy/FT/v2/TongueOut=0.7\*0.3 = OSCm/Proxy/FT/v2/TongueOut=0.91 一直递进到最后OSCm/Proxy/FT/v2/TongueOut=1时停止,这样就能实现一个平滑过程了,这种方法在远程同步中,通过逐步的参数递进,可以有效减少跳跃,达到平滑过渡效果。 #### 选修:帧速率与Smooth的关系 那了解了Smooth层的平滑原理,接下来有一个选修课,Jerry模版中使用帧速率来控制平滑值,能够更好的解决卡顿情况下的丢失动作问题。 在单独的一个Face\_Tracking\_Frame\_Time\_Counter图层中,可以找到FrameTimeCounter,新版本在统一的混合树中,这里只有一个非常多帧数的动画,用于每秒让TimeSinceLoad参数+1, [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/xMYTHRhTWft88gMW-image.png) [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/DjIEoxXFQZRl9dV2-image.png) [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/IJWwLSXtjmMGwlCT-image.png) [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/kuY5qXrVxrWYN1PV-image.png)[](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/FBP9GD6tMDAzdASO-image.png) 在Jerry6.0版本及以上中,有一套在**Smooth图层**中的几个动画,使用一些特殊参数来进行驱动Smoothing平滑参数 因为使用的是Direct类型,所以会一起执行,而第一个参数就是使用我们前面提到的**TimeSinceLoad**,用来驱动**LastTimeSinceLoad**,**因为Animator的特性,LastTimeSinceLoad一定会晚一帧与TimeSinceLoad的值同步**,而当帧数低的时候,这个同步的时间可能会更久**。**特性是:动画是由时间决定播放进度的,不会随着帧率的变化加快或减慢播放速度。同时Animator每一帧只会改变一次状态。

第二个是使用**TimeSinceLoad**来驱动**FrameTime**=1,第三个是使用**LastTimeSinceLoad**来驱动**FrameTime**=-1 第四第五和第六都是使用**FrameTime**来动态调整Smoothing的相关参数。 流程是这样子的: 首先**TimeSinceLoad**与**LastTimeSinceLoad**之间的差值**FrameTime**,会因为上面**Animator的特性**,随帧率的变化会变大变小,基本表现为帧率越高的时候差值越小,而帧数越低的时候差值越大。 所以我们可以有这样一个思路:为了避免丢失关键动作,要尽可能降低平滑,追求精准输出。而通过控制这个差值来控制我们的平滑参数,就能够实现上述想法。 而为了储存下来这个差值,我们让**TimeSinceLoad**驱动正数,而**LastTimeSinceLoad**驱动负数,这样就能把差值存入FrameTime中。 通过这个FrameTime的变化,来动态调整Smoothing的参数。一般来说差值都在0.01-0.05,所以制作驱动Smoothing参数的关键帧的时候要放大关键帧的数据,这样才能让乘算后的参数在正常值。

这里的帧速率与平滑度的数值应为计算过的,请考虑数值的严谨性或者直接使用Jerry的模版数值。

# 制作/修改动画器 其实制作动画器,真正需要手动操作的,只有上一页面提到的Driver层,其他可以通过OSCmooth来一键生成,当然如果想做到新版本Jerry模版那些细致的功能,可能需要我们去修改代码或者手动更改。 ### 1. 创建一个属于自己的BlendTree参数没有的话需要自己手动添加,具体使用何种参数,请参考[VRCFaceTracking Parameters | VRCFaceTracking (vrcft.io)](https://docs.vrcft.io/docs/tutorial-avatars/tutorial-avatars-extras/parameters)

参数在这个阶段是"FT/v2/"前缀,这是没有经过平滑的,后期会经由OSCmooth自动转化为"OSCm/Proxy/FT/v2"前缀

[](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/V8V5wUhpjaclTPTq-image.png) 反复进行这些操作,可以制作出来一份完整的Driver图层,但是从头开始做不仅麻烦,还可能会漏掉一些动作,徒增一些没必要的参数消耗,所以我们这里可以选择第二套方案,从模版中进行拷贝动画器,然后使用OSCmooth还原动画器。这个操作也许需要一点时间,而且期间Unity不会有卡顿感,这会让你觉得没有移动成功,几分钟后切换一下窗口,模版就移动过来啦~

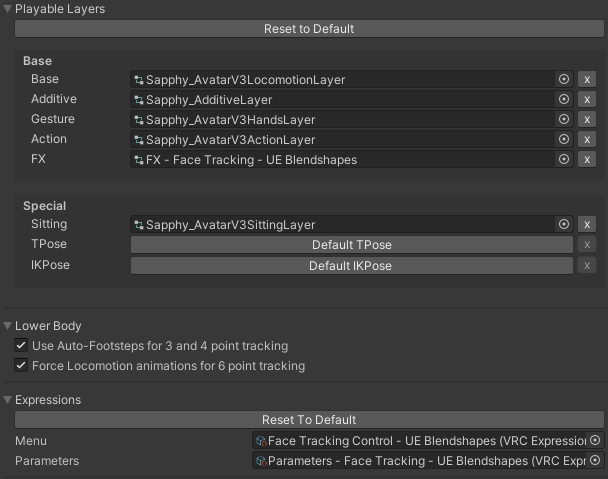

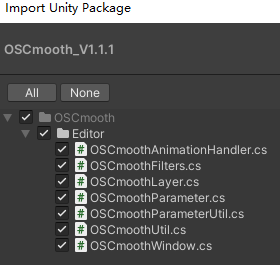

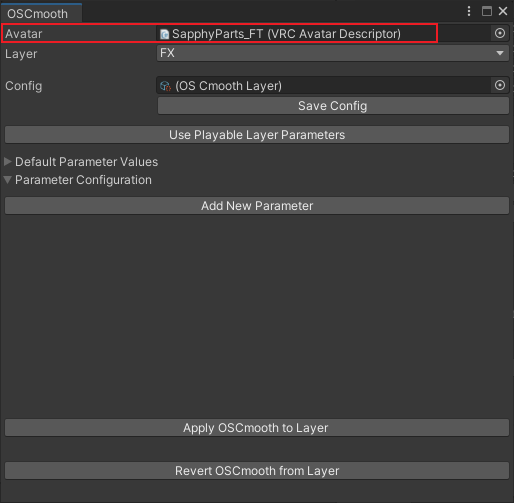

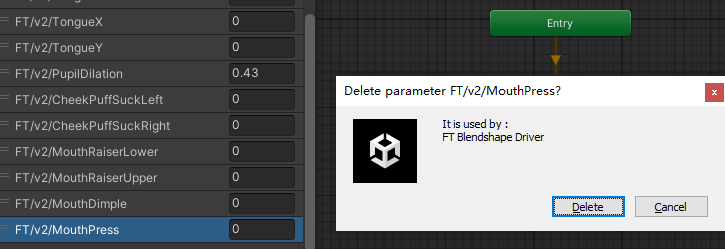

移动成功后,把我们需要的动画器(不想动源文件可以Ctrl+D复制一份)放入一个模型当中,本文以夏菲为例 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/49u0hqunKMdQiX9P-image.png) [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/WKM1bShxYmnY2jnK-image.png) 这时候导入我们的[OSCmooth-Github](https://github.com/regzo2/OSCmooth),将我们的模型拖入到其中[ ](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/Z4XqfcsZ1cNBa9NC-image.png) [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/4oU0LO4ShUFPFtHe-image.png) 选择下方的Revert OSCmooth from Layer,这样就可以将Driver层所有参数的"OSCm/Proxy/FT/v2"前缀,转化回原始的"FT/v2/"前缀,这时候,应该只有Driver一个State,没有Binary图层和Smooth图层。 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/3bABjnMP8DZ1S3jc-image.png)我们也需要删除一些参数,需要保留的仅有"FT/v2/"前缀的参数,并且不是1/2/4的二进制压缩参数

| 参数名 | 动画器/本地 | 参数表/远程同步 | 描述 |

| EyeTrackingActive | Float | Bool | 眼球追踪开启 |

| LipTrackingActive | Float | Bool | 面部追踪开启 |

| EyeDilationEnable | Float | Bool | 瞳孔追踪开启(瞳孔放大缩小,仅Tobii系可用) |

| FacialExpressionsDisabled | Bool | Bool | 关闭手势表情 |

| VisemesEnable | Bool | Bool | 口型同步开启 |

| FT/v2/xxxxxx | Float | - | 原始输入的浮点值 |

下面是需要删除的参数,特别注意FT/v2/xxxxxx是要保留的,FT/v2/xxxxxx1;FT/v2/xxxxxx2;FT/v2/xxxxxx4是要删除的

| FT/v2/xxxxxx1;FT/v2/xxxxxx2;FT/v2/xxxxxx4 | Bool | Bool | 原始输入的布尔值,之后会经由Binary转换为BinaryOut/FT/v2/xxxxxx |

| BinaryOut/FT/v2/xxxxxx | Float | - | 经过Binary后的值,之后会经由Smooth转换为OSCm/Proxy/FT/v2/xxxxxx |

| OSCm/Proxy/FT/v2/xxxxxx | Float | - | 经过Smooth后的值,之后会在Driver图层直接驱动形态键 |

| OSCm/BlendSet | Float | - | 混合树同时进行的关键参数,请保持为1 |

| OSCm/Local/FloatSmoothing | Float | - | 本地参数的通用平滑程度 |

| OSCm/Local/PupilDilationSmoothing | Float | - | 本地参数的瞳孔平滑程度 |

| OSCm/Remote/EyeLidSmoothing | Float | - | 远程参数的眨眼平滑程度 |

| OSCm/Remote/FloatSmoothing | Float | - | 远程参数的通用平滑程度 |

| OSCm/Remote/PupilDilationSmoothing | Float | - | 远程参数的瞳孔平滑程度 |

其实正常的删除参数的话,能删除就说明该参数已经没有对应的动画器占用了,所以只要删掉能删掉的就行,如果出现这个提示,说明就是这个参数是不能删的。(前提是已经删掉了Binary和Smooth层)[](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/m7XCbS5Lo9JVXkXR-image.png)

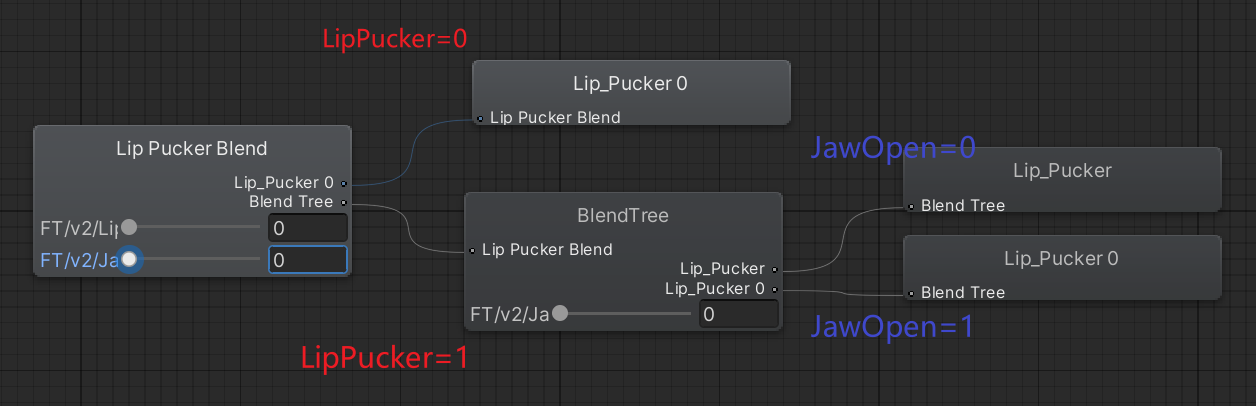

这时候就可以开始编辑我们想要的Driver层了 ### 2. 修改动画器 ##### 1.简单调整动作的幅度 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/8qoQITbU2uPBqaJD-image.png) 参数从0变到1的过程,LipPucker的形态键也从0变到100 如果想要让LipPucker更快的到达100,那么就需要**降低阈值**。例如将Lip\_Pucker.anim的阈值从1降到0.7,这样能够让参数到达0.7的时候,LipPucker就已经到达100了。参数相当于是在0-0.7的变化过程就走完了原先的0-1的变化过程,所以更加灵敏了也更加快速了。但这样做会导致参数在0.7-1.0的变化过程中,形态键都会一直在100固定。

而如果觉得不动作效果那么夸张,或者想让动作更慢一些,就需要**调高阈值**。 同理将Lip\_Pucker.anim的阈值从1升到2,那么参数即使达到了1,也只有原先0.5的效果,形态键也就只有50。一般来说参数的取值范围都是\[0,1\]或\[-1,1\],所以降低阈值也是降低了最大值。

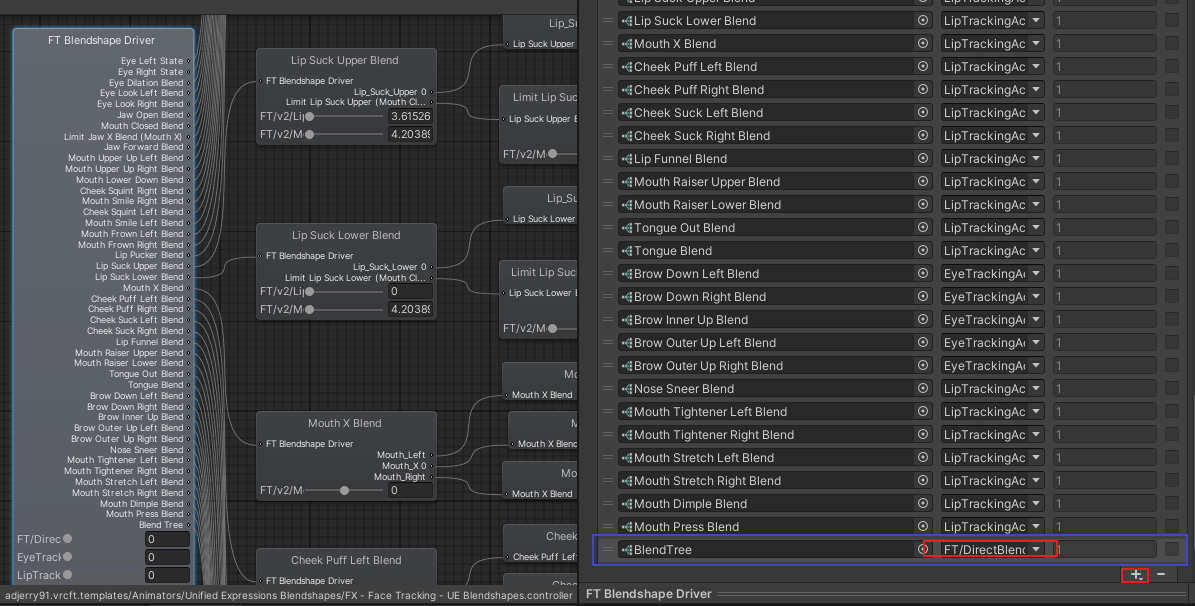

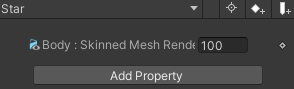

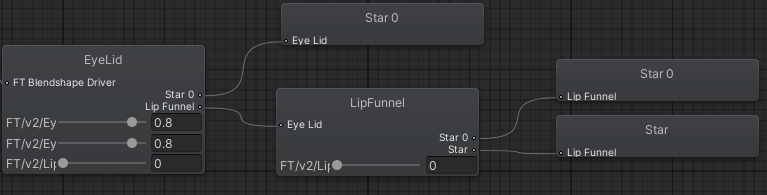

还有另一种方法来实现降低动作幅度,就是修改动画的形态键值,可以让Lip\_Pucker.anim的关键帧降为70,这样即使是参数到达了1,也只能驱动70的形态键。 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/L7cyyHGEQnRaJBXR-image.png) ##### 2.添加限制 一般情况下,单个动作直接伸出是不会穿模的,但组合动作则会很容易穿模,我们假设一个情况,如果LipPucker单独为100,没问题,JawOpen单独为100,没问题,但LipPucker和JawOpen同时为100的时候,会出现一个穿模问题,那我们现在就需要加以限制。 我们一般在比较不重要的动作做出限制,而重要的动作则直接驱动,相比之下,JawOpen是张大嘴巴,而LipPucker是噘嘴,JawOpen重要性大,我们在LipPucker上加一些逻辑限制。 我们的大体思路是,LipPucker=1且JawOpen=0的时候,形态键LipPucker=100,但如果LipPucker=1且JawOpen=1,则形态键LipPucker=0 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/bxyNwoSlTpWg7Gdz-image.png) 那我们就需要修改原本在Lip\_Pucker位置的动画为混合树,删除原来的Motion,添加新的BlendTree [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/p1ks46bcniCJEJrU-image.png) 修改参数为JawOpen,添加两个Motion。 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/flKjgBy05mIPo18g-image.png) 为了实现JawOpen的限制效果,我们这样填入动画文件 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/LWuyswTzTbC90us4-image.png) 然后最后就有这么一个逻辑: [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/DjliQB9Xrlv0HHDQ-image.png) ##### 3.添加联动动作 这里提供一个制作简单联动的例子,供大家参考思路。 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/O73vqxqulPEMpm0P-image.png) 在最顶级的根混合树添加一个新的混合树,请记得更改参数让这个混合树正常加入计算,如果想要常驻,那就使用FT/DirectBlend,如果要让联动的动作与眼追或嘴追一起开启,那就更改为LipTrackingActive/EyeTrackingActive。 我们现在要制作一个张大眼睛的时候,如果是嘟嘴,就触发星星眼的效果。这需要联系两种参数,EyeLid和LipFunnel。 首先我们需要录制一个模型的Body上的一个星星眼表情,根据需要可以录制多帧或者单帧。同时我们需要录制一个相同形态键的0值的动画。 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/Wkqdfn5qNIjG738G-image.png) [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/owh1jkWKN7WNuOdx-image.png)[](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/SKuHFn8TkCe3TKtO-image.png)如果是多帧动画不想循环,请关闭Anim文件的LoopTime(循环时间)以避免动画循环播放,单帧动画也建议关闭

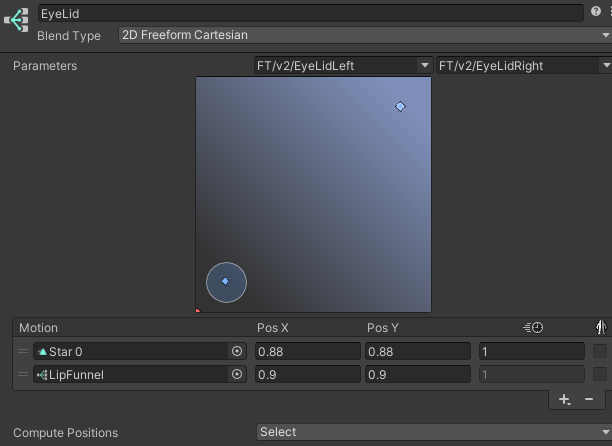

逻辑:EyeLidLeft和EyeLidRight>0.9,且LipFunnel>0.5时,触发Star [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/AAt0pCawgXGcNV2A-image.png)逻辑图如上,需要注意正常的眨眼参数是:0.8默认;0.8→1.0瞪眼;0.8→0闭眼,所以我们选择0.9的时候触发

[](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/cmlGOJLvKBE8n6r9-image.png)Star0的位置是靠近且小于0.9的一个数值,而不是正常眼睛下的0.8,因为如果使用0.8到0.9触发的话,会让Star表情有一个慢慢出来的动作,可能会导致一些不必要的视觉BUG,所以要尽可能的缩短这一个行程。关于2D混合树的详细解释,请见本章上一页:[动画器详解 | VRCD 文档库](https://docs.vrcd.org.cn/books/vrcfacetracking/page/eddea)。

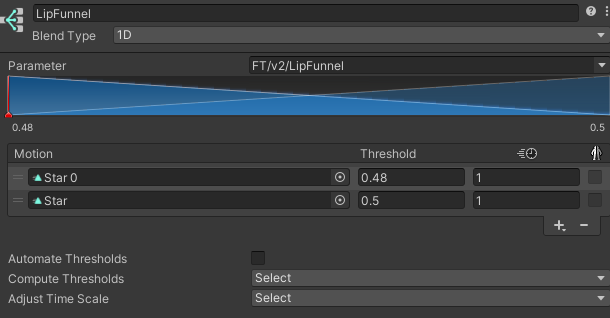

[](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/zWB6gl245XCGjdxf-image.png)第二层嵌套使用1D混合树,用LipFunnel参数,同样的,使用了靠近且小于0.5的数值,尽可能让这个行程缩短,不要让Star有渐入渐出的效果。

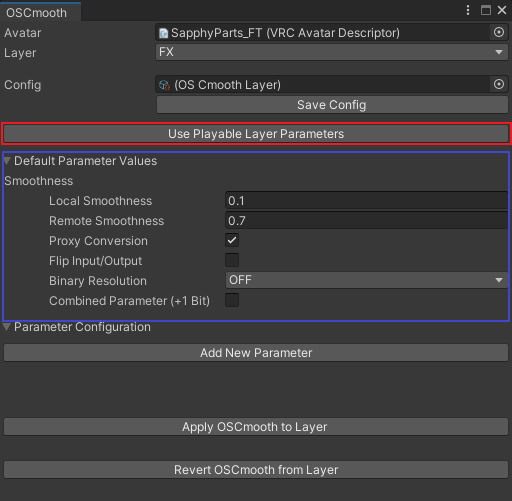

### 3. 使用OSCmooth完成后续处理 在我们确定好Driver层已经完工,没有需要新增的参数和新增的混合树之后,我们进入OSCmooth的操作页面进行下一步处理。 将我们做好的Driver层所在的动画器放入Avatar的Playable Layers,然后把Avatar放入OSCmooth中。 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/UtYWkPga5S8kDFJq-image.png)红框为**自动识别动画器内的参数**并填入,篮框内的为全局默认设置,我们可以不用在这里调整。我们点击红框的按钮。

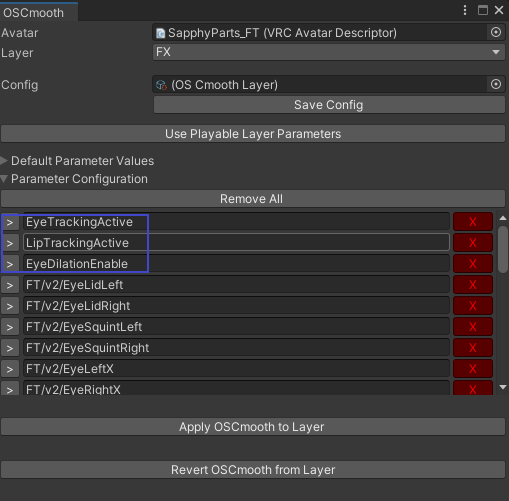

[](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/3Ncl31wefSSddbBW-image.png)在这里我们需要删掉不带有"FT/v2/"前缀的参数,仅保留面捕Driver中所需要的参数。

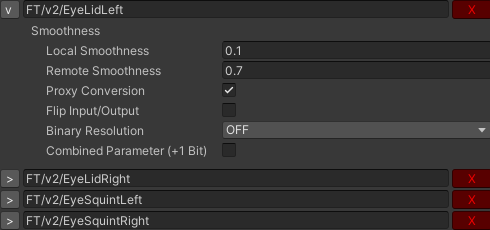

[](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/xa08RGHHGLFhszi0-image.png) **LocalSmoothness**即是本地平滑参数,最大为1 **RemoteSmoothness**是远程平滑参数,最大为1**在这里我们需要强调,OSCmooth生成的Smooth层,平滑参数越高,平滑程度越高。**

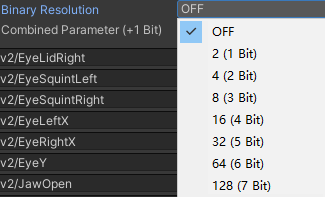

**Proxy Conversion**是自动将Driver层中的FT/v2前缀参数转换为为平滑后的OSCm/Proxy/FT/v2前缀 **Flip Input/Output**是将平滑层中的输入和驱动的参数互换,一般情况无需使用 **Binary Resolution**则是我在[基本原理 | VRCD 文档库](https://docs.vrcd.org.cn/books/vrcfacetracking/page/a8f15)中讲到的二进制压缩的选择,你可以根据自己的需求来调整,1个Bool就能表达2种情况,2个Bool就是4种情况,3个Bool就是8种情况[](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/bYtJrjdeoZtON8NZ-image.png) Combined Parameter是加入一个反向负值,在为互斥的动作进行参数配给的时候,一般可以使用同一个参数的正负两极来节约参数,这时候可以使用这一个选项,例如MouthX1、MouthX2、MouthX4、MouthXNegative,就能实现MouthX从-1到1的变化,也就是嘴巴的左和右| float | -1 | -0.857 | -0.714 | -0.571 | -0.429 | -0.286 | -0.143 | 0 | 0.143 | 0.286 | 0.429 | 0.571 | 0.714 | 0.857 | 1 |

| bool | 111N | 110N | 101N | 100N | 011N | 010N | 001N | 000 | 001 | 010 | 011 | 100 | 101 | 110 | 111 |

| 不使用二进制压缩的参数 |

| EyeLidLeft/EyeLidRight |

| EyeLeftX/EyeRightX |

| EyeY |

| JawOpen |

| MouthClosed |

| 值得用4个Bool的参数 | 只需用2个Bool的参数 |

| MouthUpperUp | NoseSneer |

| MouthLowerDown | MouthTightenerLeft/MouthTightenerRight |

| MouthX | LipSuckUpper/LipSuckLower |

| MouthDimple | |

| MouthPress |

| 参数 | 本地平滑度 | 远端平滑度 |

| EyeLidLeft/EyeLidRight | 0.15 | 0.7 |

| EyeLeftX/EyeRightX | 0.15 | 0.7 |

| EyeY | 0.15 | 0.7 |

| PupilDilation | 0.7 | 0.95 |

| 其它参数 | 0.7 | 0.7 |

如果您使用Modular-Avatar的话,使用MA Parameter组件自行进行参数表的写入,本文不做详细操作解释

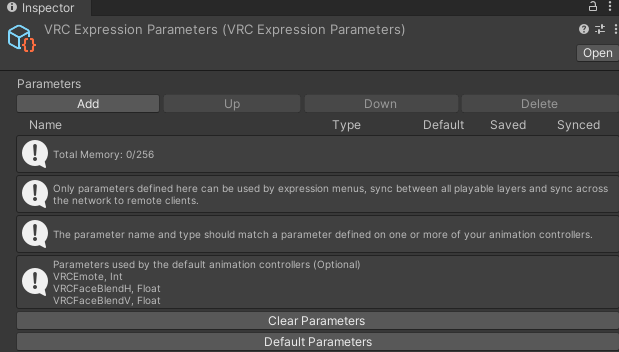

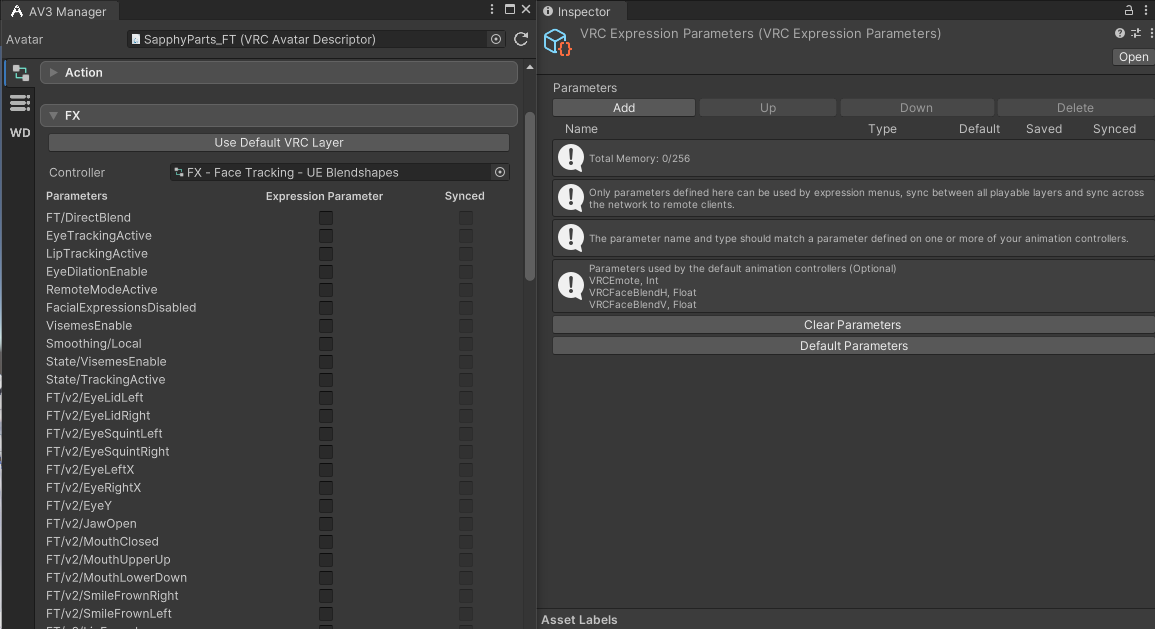

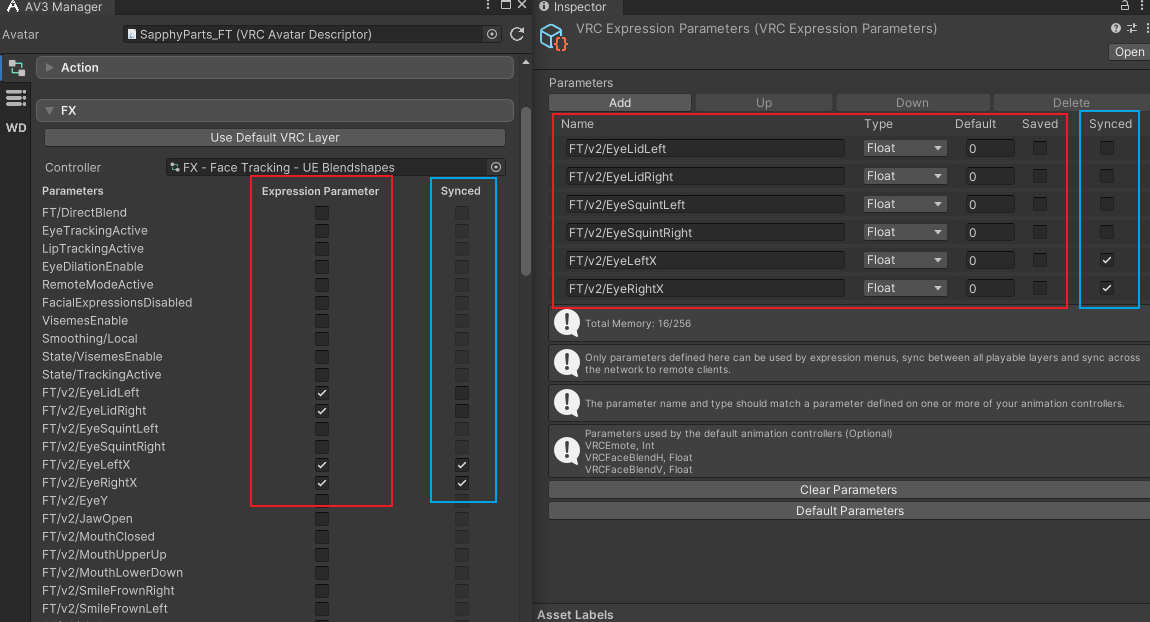

### 参数表制作/修改 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/zrWBCZX56KwASN8O-image.png) 这里新建一个新的参数表来让演示。打开VRLab-Avatar3Manager,将Avatar放入其中,点开FX层,能看到我们所有在动画器内的参数。 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/hChWpDsaOrpbnTxs-image.png) 这时候我们需要将我们需要的参数在左边勾选,就能够自动填写到右边的参数表中。,勾选Expression Parameter则会填入参数表,但要勾选Synced才是能真正远端同步(占用参数容量)。 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/U7uoR1ZHu8vVtNMJ-image.png) 这时候我们需要明确,什么参数需要同步(Synced),这取决与以下几点 1. 勾选基础参数,主要的有EyeTrackingActive、LipTrackingActive、FacialExpressionsDisabled、VisemesEnable,从高版本模版中修改的话还有RemoteModeActive、Smoothing/Local。 2. 未启用Binary(在OSCmooth中Binary选项为OFF)的参数请对他们本身进行同步勾选。例如:EyeLidLeft→EyeLidLeft 3. 启用了Binary的参数请对他们的二进制化参数进行同步勾选。例如:MouthX→MouthX1、MouthX2、MouthX4 4. 启用了Combined Parameter的参数请记住**勾选二进制化参数的同时勾选Negetive**,例如:MouthX→MouthXNegative其实就是有二进制化的参数就勾选二进制化,没有的就勾选它本身,有相反值的就连着相反值一起勾上

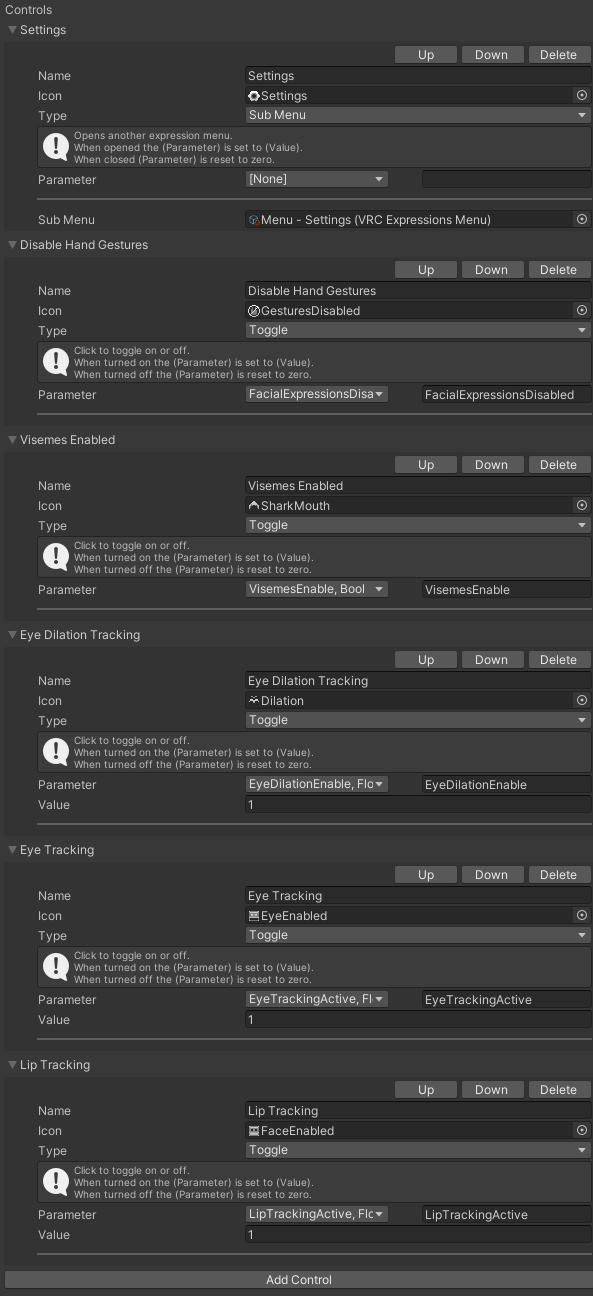

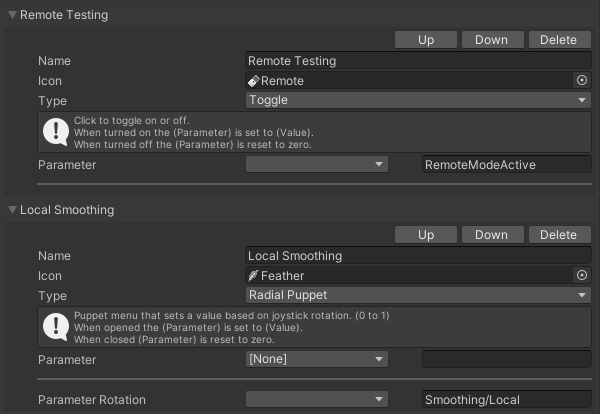

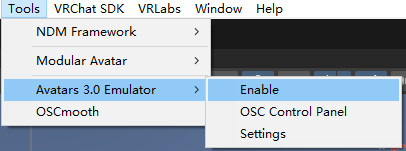

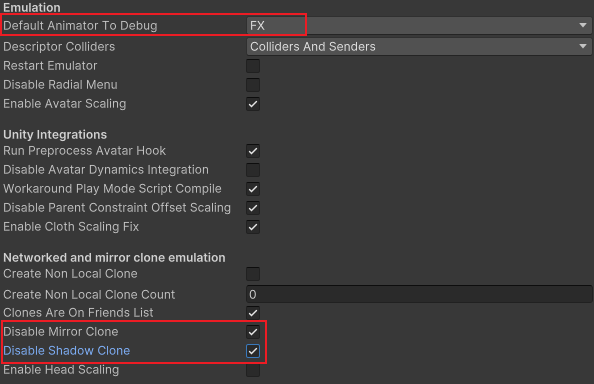

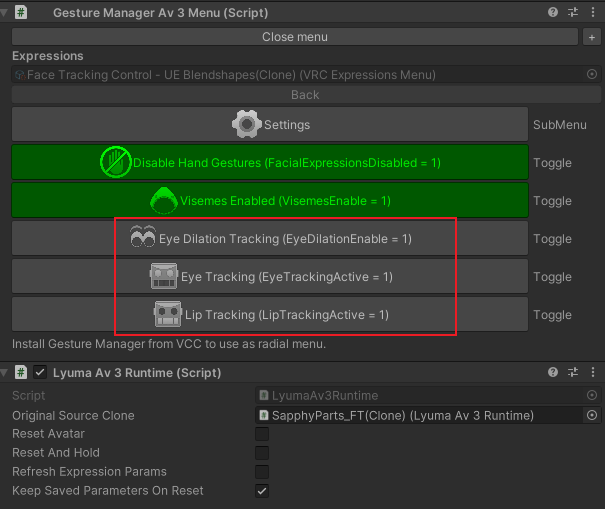

### 菜单制作/修改 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/ZBhYd0nf4gvEayK1-image.png) [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/4DIkTct9Jk6cCcka-image.png) 以上是Jerry模板中的菜单,可以供参考,也可以直接用模版中的菜单,这里没什么特别的,只需要明确参数和开关是干什么用的就行 基本就是Eye是眼睛、Lip是嘴巴、Dilation是瞳孔。 ### 测试 目前我们常用的有两种调试的工具[Avatar3Emulator](https://github.com/lyuma/Av3Emulator)(曾用名LyumaEmulator)和[GestureManager](https://github.com/BlackStartx/VRC-Gesture-Manager),这两个工具可以共存,于我主观看法,无论是操作手感还是功能数量,我都是强烈推荐**Av3Emulator。**而GestureManager在我看来唯一的优势是圆盘菜单的美观性,但我需求不大,且共存时可以使用Av3Emulator的功能和GestureManager的菜单,这里就只细讲Av3Emulator的调试方法。 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/yC0xzQBp41h9Dtnv-image.png) 使用顶置Tools菜单打开Av3Emulator,会自动生成一个物体,点击可以调整部分设置,建议将红框处按图示修改,以节省播放模式下的性能消耗。随后进入播放模式。 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/gp3nqqS9CZIjtx7v-image.png) 开启主要的三个功能 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/DXAU97OV2QIREPaP-image.png)[](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/2xuvq41ZDJKrvj7s-image.png) 这下方有一个User Input,这里可以调整用户输入的每一个参数,在这里调整参数,看模型对应的形态键是否被正确驱动以及幅度是否合适。使用了Binary的情况下需要手动调整xxx1、xxx2、xxx4(Bool)来控制最终驱动形态键的参数OSCm/Proxy/FT/v2/xxxxx,而没有启用Binary的可以直接使用xxx(Float)来驱动OSCm/Proxy/FT/v2/xxx

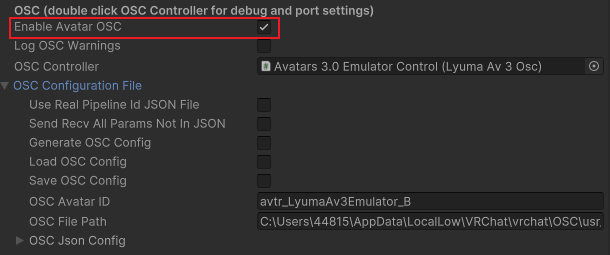

同时,我们可以使用OSC来直接在Unity内带上VR,查看实际的效果。为了顺利进行测试,需要你具备面捕设备+VRCFT(5.1.1.x)+做好了一切的面捕模型,如果出现不输入OSC数据或者只有部分数据,可以点击勾选再取消勾选Use Real Pipeline ID JSON File来刷新一次OSC config。 [](https://docs.vrcd.org.cn/uploads/images/gallery/2024-09/EnzNFLaugHqBwWUO-image.png)VRCFT需要开启Force Relevancy才能正常输入到Unity中,而目前的最新版本5.2.3.0版本中Force Relevancy没有实际效果,所以要使用此功能请等待新版本更新或者回退到5.1.1.x版本。

### 最后,让我们上传这个最终成果吧!